可解释人工智能 (XAI) 的兴起及其重要性

可解释人工智能(XAI)是一个新兴领域,在商业领域的需求日益增长。它旨在帮助人们理解和解释人工智能(AI)和机器学习(ML)模型的工作原理。

在当今数据驱动的世界中,人工智能已成为关注的焦点。各种人工智能解决方案被广泛应用于各行各业,以推动增长并优化运营。

XAI 的一个关键作用是帮助我们理解 AI 模型如何做出决策,并给出相应的输出。如果你还不太清楚为什么需要关注 XAI,那么这篇文章会为你解答。

让我们开始吧!

什么是可解释人工智能?

可解释人工智能(XAI)指的是一组方法和技术,旨在提高用户对 AI 模型输出和结果的理解和信任。本质上,XAI 旨在揭示复杂的机器学习算法的内部工作机制,以及驱动这些模型决策背后的逻辑。

通过其框架和工具集,XAI 为 AI 模型添加了一个透明层,使得用户可以理解预测背后的原理。这在广泛采用 AI 的组织中尤为重要,因为它提高了人工智能的准确性、可靠性和透明度。

此外,XAI 有助于识别复杂的机器学习算法在处理特定结果时可能产生的偏见和问题。传统的“黑盒”机器学习模型难以理解,即使是创建这些模型的科学家也很难理解。

因此,XAI 所提供的透明度使组织能够正确利用 AI 的潜力并做出明智的决策。XAI 所提供的可解释性通常以文本或视觉形式呈现,为我们深入了解 AI 模型的内部运作提供了可能。

为了阐释 AI 模型的附加元数据信息,XAI 还采用了多种解释机制,例如特征相关性、简化解释和示例解释。

随着越来越多的组织在其业务中实施 XAI,对 XAI 的需求正在迅速增加。同时,用于解释的技术和方法也在不断改进。

为什么 XAI 如此重要?

目前,许多组织在其业务运营中使用人工智能模型,并依据人工智能的预测来做出未来的决策。 然而,人工智能模型的准确性并非完美,并且可能存在偏差,这是 AI 模型中普遍存在的问题。

偏差的产生有很多原因,并且会对 AI 模型的决策产生负面影响。特别值得注意的是,当 AI 模型处理的数据与训练数据存在差异时,其决策能力通常会下降。

此外,机器学习模型和神经网络的解释过程可能非常复杂,即使是数据科学家也可能难以理解。如果完全依赖 AI 模型来做出所有关键决策,可能会导致不可预见的问题并阻碍公司的整体发展。

因此,对于组织来说,了解 AI 模型提出的每个结果背后的决策过程和逻辑至关重要。 XAI 在此背景下扮演了关键角色,它能够帮助组织全面理解 AI 模型的决策过程以及所采用的逻辑。

从理解机器学习算法到评估神经网络和深度学习网络,XAI 能够帮助我们监控所有环节,并为每个决策提供准确的解释。 实施 XAI 可以更直接地评估每个 AI 决策的准确性和可靠性,从而帮助组织决定是否适合采用该决策。

此外,XAI 还是在业务生态系统中实施和维护负责任的 AI 模型的重要组成部分,有助于确保决策的公平性和准确性。 XAI 还可以增强最终用户的信任,同时降低安全和合规风险。

XAI 的工作原理

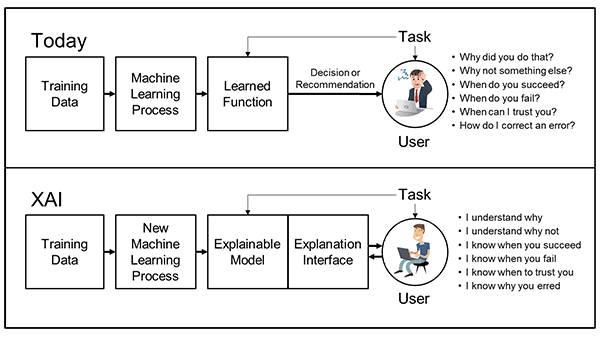

目前企业所采用的现代人工智能技术,通过使用不同的模型来提供结果或决策。但是,这些人工智能技术通常不会解释它们得出结果或决策背后的逻辑。

图片来源:Darpa

图片来源:Darpa

为了弥补这一差距,企业正在引入 XAI。它利用可解释的模型和所有带解释接口的元数据信息,从而帮助理解 AI 模型的工作方式。

当人工智能技术被集成到商业生态系统时,各种人工智能方法被逐步引入,包括机器学习(ML)、机器推理(MR)以及 MR 和 ML 的集成。

具体来说,XAI 在现有 AI 模型中引入的组件包括解释、数据的可解释性、MR 的可解释性和 ML 的可解释性。 此外,XAI 还引入了 MR 和 ML 之间相互作用的可解释性。

XAI 的工作主要分为以下三种类型:

- 可解释数据:它强调用于训练 AI 模型的数据类型和内容。此外,它还展示数据选择的原因、选择过程以及消除偏见所需要的努力。

- 可解释预测:XAI 在此层面会解释 AI 模型用于获取输出的所有特征。

- 可解释算法:这部分会揭示 AI 模型中的所有层,并阐释每一层如何有助于产生最终输出。

然而,可解释的预测和算法目前仍处于发展阶段,只有可解释数据能够用于解释神经网络。

为了解释决策过程,XAI 采用了两种主要方法:

- 代理建模:在这种方法中,会使用一个与原始模型不同的近似模型。这种方法会产生近似的结果,可能与实际结果存在差异。

- 可解释性设计:这是一种常见的方法,XAI 会创建一个易于人类理解的模型。但是,与实际的人工智能模型相比,这些模型在准确性或生产能力方面可能会有所不足。

XAI 的优势

可解释的人工智能(XAI)对 AI 的发展产生了深远影响,因为它有助于人类理解 AI 的工作原理。它提供了许多好处,例如:

提高透明度和信任度

将 AI 模型集成到其系统中的企业可以深入了解复杂 AI 模型的工作原理,以及它们在不同条件下产生特定输出的原因。

XAI 对于帮助企业了解“黑盒”模型结果背后的原因非常有用。因此,它提高了机器和人类用户之间的透明度和信任度。

加强人工智能模型的采用

随着组织开始理解 AI 模型背后的工作原理和逻辑过程,并认识到它的好处,AI 模型的采用率正在增加。通过充分的解释,他们将更加信任自己所做出的决定。

提高生产力

通过在 AI 模型中采用 XAI,机器学习(ML)运营团队可以轻松地发现现有系统中的错误,并找到需要改进的地方。 这也有助于 ML 运营团队确保 AI 流程的平稳高效运行。

因此,生产力将会得到显著提高,因为 ML 运营团队可以理解导致 AI 模型产生特定输出的逻辑。

降低风险和成本

XAI 在降低 AI 模型管理成本方面发挥了重要作用。因为它能够解释所有结果和潜在风险,从而最大限度地减少人工检查的需求,并降低可能损害与最终用户关系的昂贵错误的发生几率。

发现新机会

当技术和业务团队有机会深入了解 AI 决策过程时,他们将有机会发现新的机会。通过更深入地了解特定结果,他们可能会发现最初被忽略的事物。

XAI 的挑战

XAI 的一些常见挑战包括:

- 解释的难度:许多机器学习系统难以解释。因此,XAI 提供的解释对于用户来说可能难以理解。当“黑盒”策略无法解释时,可能会导致严重的运营和道德问题。

- 公平性:XAI 很难确定 AI 的特定决策是否公平。公平性在很大程度上是主观的,并且取决于训练 AI 模型所使用的训练数据。

- 安全性:XAI 的一个主要问题是,客户可能会利用 XAI 所提供的解释来操纵机器学习模型的决策过程,并影响输出,以获取个人利益。技术人员只能恢复用于训练算法的数据集。

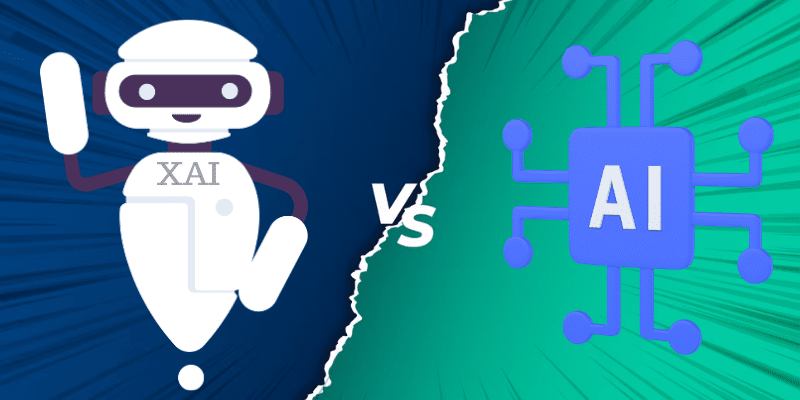

XAI 和 AI 的区别

虽然 XAI 和 AI 都与人工智能有关,但它们之间存在一些根本的区别。

| XAI (可解释人工智能) | AI (人工智能) |

| 为复杂的机器学习模型决策过程提供解释或逻辑。 | 仅提供机器学习模型所做出的决策或输出结果。 |

| 由于 XAI 提供了适当的解释,它可以帮助用户更加信任特定的 AI 模型。 | 用户只能得到结论,而对 AI 如何得出结论感到困惑。因此,决策需要更多的信任。 |

| 它降低了与许多 AI 模型相关的偏见。 | 它经常根据世界上存在的偏见做出决策。 |

| 降低了 AI 模型犯错的成本。 | AI 模型并非百分之百准确,可能会做出错误的预测。 |

| XAI 尚未完全发展成熟,仍然存在局限性,特别是在解释复杂的黑盒模型方面。 | 人工智能作为一个整体已经取得了很大的进展,可以快速解决很多问题,而不会有太多麻烦。 |

| 由于 XAI 会解释 AI 模型的每个逻辑和决策过程,因此任何人都可能恶意地影响该过程。 | AI 模型不提供其最终预测背后的主要原因或逻辑,因此几乎没有人有机会影响其决策。 |

XAI 对不同行业的影响

XAI 的出现对人工智能在决策中起着至关重要作用的各个领域产生了重大影响。 让我们来看一些例子。

#1. 金融

人工智能驱动的解决方案在金融领域占主导地位,大多数公司都将它们用于各种任务。 然而,金融部门受到严格监管,在做出财务决策之前需要进行大量审计。

XAI 可以在这方面提供帮助,解释财务决策背后的理由。 这有助于保持最终用户的信任,因为他们可以了解组织做出财务决策背后的原因。

#2. 医疗保健

XAI 的加入在多个方面使医疗保健系统受益。 它可以帮助检测和诊断许多疾病,并找出根本原因。 这可以帮助医生提供正确的治疗。

#3. 制造业

如今,人工智能模型在制造业中被广泛采用,用于管理、维修、物流等。但是,这些人工智能模型并不总是保持一致,这会导致信任问题。

XAI 可以解决这些问题,因为它能为许多制造应用程序提供最佳方案,并给出解释。它将展示为员工所做的特定决定背后的逻辑和原因,最终有助于建立信任。

#4. 汽车

将 XAI 集成到自动驾驶汽车中势在必行,因为它能够让车辆在发生事故时解释其所做的每个决定。通过学习不同的情况和事故,XAI 能够帮助自动驾驶汽车做出决策,并提高乘客和行人的整体安全性。

学习资源

除了以上信息之外,如果你想了解更多关于 XAI 的信息,可以参考以下书籍和课程。

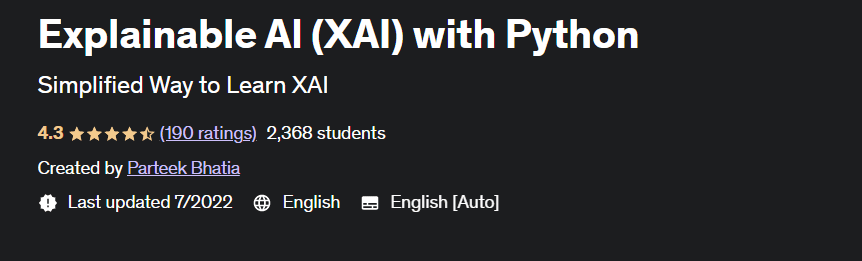

#1. 使用 Python 解释 AI

Udemy 上的“使用 Python 解释 AI”课程由 Parteek Bhatia 设计。它可以帮助你了解 XAI 的各个方面,包括其应用、各种 XAI 技术以及来自 Google 的 What-if 工具。你还将了解 XAI 在各个方面的分类。

#2. 机器学习建模管道

如果你想学习可解释人工智能(Explainable AI)并获得实现管理建模资源的工具和技术的知识,那么 Coursera 上的“机器学习建模管道”课程非常适合你。

它是备受好评的课程之一,由知名讲师 Robert Crowe 教授。你还将获得关于模型分析和可解释性的长时间教学。

#3. 可解释人工智能

《可解释的人工智能》(Explainable AI)由 Uday Kamath 和 John Liu 合著,是一本学习机器学习可解释性的优秀书籍。

你可以在书中找到许多关于 XAI 的案例研究和相关资料。本书的作者提供了许多有助于理解 XAI 的实用示例。

#4. 使用 Python 的动手可解释 AI (XAI)

《使用 Python 的动手可解释 AI (XAI)》是 Denis Rothman 撰写的一本著名书籍。

它详细探讨了 XAI 的工具和技术,以理解现代企业所需的人工智能结果。你还将学习处理和避免与 AI 偏见相关的各种问题。

结论

可解释人工智能(XAI)是一个有效的概念,它可以让企业主、数据分析师和工程师轻松理解 AI 模型的决策过程。 XAI 可以解释那些连数据科学家也无法解码的复杂机器学习模型。

尽管 XAI 正在不断发展,但仍有一些地方需要改进。 我希望本文能让你更清楚地了解 XAI、其工作原理、其好处和挑战以及在不同领域的应用。 你也可以参考上述课程和书籍,以获得更多关于 XAI 的见解。

你还可以阅读关于狭义人工智能 (ANI) 的文章。