云端 GPU:人工智能和海量工作负载的理想选择

随着深度学习、人工智能和机器学习等前沿技术的蓬勃发展,市场对云端 GPU 的需求持续攀升。

如果您的组织需要处理 3D 可视化、机器学习 (ML)、人工智能 (AI) 或其他类型的大规模计算任务,那么选择合适的 GPU 计算方式至关重要。

传统上,组织内深度学习模型的训练和计算过程耗时较长,不仅浪费时间,还带来了高昂的成本以及存储和空间方面的难题,最终降低了生产效率。

新一代 GPU 的出现正是为了解决上述问题。它们能够高效地并行执行繁重的计算任务,显著加快 AI 模型的训练速度。

根据 Indigo 的研究表明,在训练与深度学习相关的神经网络时,GPU 的性能比 CPU 快 高达 250 倍。

随着云计算技术的进步,云 GPU 逐渐兴起,它以更快的性能、便捷的维护、更低的成本、快速的扩展能力以及节省时间等优势,正在深刻地改变数据科学和其他新兴技术领域。

本文将为您深入解析云 GPU 的概念,探讨其与 AI、ML、深度学习之间的紧密关系,并为您介绍一些部署首选云 GPU 的优质平台。

让我们开始吧!

什么是云 GPU?

要理解云 GPU,我们首先需要了解 GPU 的概念。

图形处理单元 (GPU) 是一种专门的电子电路,旨在快速修改和操作内存,以加速图像或图形的创建过程。

由于其并行结构,现代 GPU 在处理图像和计算机图形方面的效率比中央处理单元 (CPU) 高得多。GPU 可以集成在主板上,也可以安装在 PC 的显卡或 CPU 芯片上。

云图形单元 (GPU) 是指具有强大硬件加速功能的计算机实例,它能够帮助在云端运行应用程序,以处理大量 AI 和深度学习工作负载。使用云 GPU 不需要在设备上部署物理 GPU。

一些常见的 GPU 品牌包括 NVIDIA、AMD、Radeon 和 GeForce 等。

GPU 的应用领域非常广泛:

- 手机

- 游戏主机

- 工作站

- 嵌入式系统

- 个人电脑

GPU 的用途有哪些?

以下是一些 GPU 的典型应用场景:

- 在 AI 和 ML 中进行图像识别

- 3D 计算机图形和 CAD 图纸的计算

- 纹理映射和渲染多边形

- 几何计算,例如顶点到坐标系的平移和旋转

- 支持可编程着色器来操作纹理和顶点

- GPU 加速的视频编码、解码和流式传输

- 图形丰富的游戏和云游戏

- 需要通用 GPU 并行处理能力的大规模数学建模、分析和深度学习

- 视频编辑、平面设计和内容创作

云 GPU 的优势是什么? 👍

使用云 GPU 的主要优势包括:

高度可扩展性

随着组织规模的扩大,工作负载也会相应增加。您需要一种能够随工作负载增长而扩展的 GPU 解决方案。云 GPU 正是为此而生,您可以轻松地添加更多 GPU 以满足日益增长的需求。反之,如果您需要缩小规模,也可以快速实现。

最大限度地降低成本

相比购买价格昂贵的高功率物理 GPU,租用云 GPU 是一种更经济的选择。您只需按小时支付使用费用,这与物理 GPU 不同,即使您不经常使用,也要承担高昂的成本。

释放本地资源

云 GPU 不会占用您本地设备的资源,这与占用计算机大量空间的物理 GPU 不同。更不用说,如果您运行大型 ML 模型或渲染任务,还会降低计算机的运行速度。

因此,您可以考虑将计算能力外包给云端,从而减轻本地计算机的负担,并轻松地使用它来控制任务,而不是让它承受处理所有工作负载和计算任务的压力。

节省时间

云 GPU 为设计人员提供了快速迭代的灵活性和更快的渲染时间。通过在几分钟内完成过去需要数小时或数天才能完成的任务,您可以节省大量时间,从而显著提高团队的生产力。这样,您就可以将时间投入到创新而不是渲染或计算上。

GPU 如何助力深度学习和人工智能?

深度学习是人工智能的基础。它是一种先进的机器学习技术,它借助人工神经网络 (ANN) 来强调表征学习。深度学习模型常被用于处理大型数据集或需要高计算能力的流程。

那么,GPU 在这里发挥什么作用呢?

GPU 旨在执行并行计算,即同时执行多个计算。GPU 可以充分发挥深度学习模型的能力,以加速大型计算任务。

由于 GPU 具有大量的内核,它们提供了卓越的并行处理计算能力。此外,它们还具有更高的内存带宽,可以容纳深度学习系统所需的大量数据。因此,它们被广泛应用于训练 AI 模型、渲染 CAD 模型、玩图形密集型视频游戏等领域。

此外,如果您想同时尝试多种算法,您可以分别运行多个 GPU。这使得不同的进程可以在不同的 GPU 上并行执行,而不会相互干扰。为此,您可以使用不同物理机器上的多个 GPU,或在单台机器上使用多个 GPU,以分担繁重的数据模型计算任务。

如何开始使用云 GPU

开始使用云 GPU 并非难事。事实上,只要您理解基本原理,一切都会变得简单快捷。首先,您需要选择一个云 GPU 提供商,例如 Google Cloud Platform (GCP)。

接下来,注册 GCP 帐户。您可以利用它所提供的所有标准优势,例如云功能、存储选项、数据库管理、与应用程序的集成等等。您还可以使用他们的 Google Colaboratory,它类似于 Jupyter Notebook,可以免费使用一个 GPU。最后,您可以开始为您的应用场景渲染 GPU。

现在,让我们看看云 GPU 处理 AI 和海量工作负载的各种选择。

Linode

Linode 为视频处理、科学计算、机器学习、人工智能等并行处理工作负载提供按需 GPU。它提供由 NVIDIA Quadro RTX 6000、Tensor、RT 内核加速的 GPU 优化虚拟机,并利用 CUDA 功能执行光线追踪工作负载、深度学习和复杂处理。

通过从 Linode GPU 获取访问权限以利用 GPU 功能并从云的真正价值主张中受益,将您的资本支出转化为运营支出。此外,Linode 让您可以专注于核心竞争力,而不必担心硬件。

Linode GPU 消除了将它们用于视频流、人工智能和机器学习等复杂用例的障碍。此外,每个实例最多可获得 4 张卡,具体取决于您预计工作负载所需的计算能力。

Quadro RTX 6000 拥有 4,608 个 CUDA 核心、576 个 Tensor 核心、72 个 RT 核心、24 GB GDDR6 GPU 内存、84T RTX-OPS、10 Giga Rays/秒光线追踪,以及 16.3 TFLOPs 的 FP32 性能。

专用加 RTX6000 GPU 计划的价格为 1.5 美元/小时。

Paperspace Core

使用下一代加速计算基础架构增强您的组织工作流程 Paperspace Core。它提供了一个易于使用和直接的界面,为 Mac、Linux 和 Windows 提供简单的入门、协作工具和桌面应用程序。使用它通过无限的计算能力运行高需求的应用程序。

CORE 提供闪电般的网络、即时配置、3D 应用程序支持以及用于编程访问的完整 API。 通过在一个地方轻松直观的 GUI 获得您的基础架构的完整视图。 此外,通过 CORE 的管理界面获得出色的控制,该界面具有强大的工具,允许您过滤、分类、连接或创建机器、网络和用户。

CORE 强大的管理控制台可以快速执行任务,例如添加 Active Directory 集成或 VPN。 您还可以轻松管理复杂的网络配置,只需单击几下即可更快地完成任务。

此外,您会发现许多集成是可选的,但对您的工作很有帮助。 使用此云 GPU 平台获得高级安全功能、共享驱动器等。 通过获得教育折扣、计费提醒、按秒计费等,享受低成本 GPU。

以 0.07 美元/小时的起始价格为工作流程增加简单性和速度。

谷歌云 GPU

获取用于科学计算、3D 可视化和机器学习的高性能 GPU 谷歌云 GPU。它可以帮助加速 HPC,选择广泛的 GPU 以匹配价格点和性能,并通过机器定制和灵活的定价最大限度地减少您的工作量。

他们还提供许多 GPU,例如 NVIDIA K80、P4、V100、A100、T4 和 P100。此外,Google Cloud GPU 可平衡每个实例中的内存、处理器、高性能磁盘和多达 8 个 GPU,以应对单个工作负载。

此外,您还可以访问行业领先的网络、数据分析和存储。 GPU 设备仅在某些区域的特定区域中可用。 价格将取决于地区、您选择的 GPU 和机器类型。 您可以通过在 Google Cloud 定价计算器中定义您的要求来计算您的价格。

或者,您可以选择以下解决方案:

弹性 GPU 服务

弹性 GPU 服务 (EGS) 通过 GPU 技术提供并行且强大的计算能力。 它是视频处理、可视化、科学计算和深度学习等许多场景的理想选择。 EGS 使用多个 GPU,例如 NVIDIA Tesla M40、NVIDIA Tesla V100、NVIDIA Tesla P4、NVIDIA Tesla P100 和 AMD FirePro S7150。

您将获得在线深度学习推理服务和培训、内容识别、图像和语音识别、高清媒体编码、视频会议、源电影修复和 4K/8K 高清直播等好处。

此外,还可以获得视频渲染、计算金融、气候预测、碰撞模拟、基因工程、非线性编辑、远程教育应用程序和工程设计等选项。

- GA1 实例提供多达 4 个 AMD FirePro S7150 GPU、160 GB 内存和 56 个 vCPU。它包含 8192 个内核和 32 GB GPU 内存,并行工作并提供 15 TFLOPS 的单精度和 1 TFLOPS 的双精度。

- GN4 实例提供多达 2 个 NVIDIA Tesla M40 GPU、96 GB 内存和 56 个 vCPU。它包含 6000 个内核和 24 GB GPU 内存,可提供 14 TFLOPS 的单精度。 同样,您会发现许多实例,例如 GN5、GN5i 和 GN6。

- EGS 内部支持 25 Gbit/s 和高达 2,000,000 PPS 的网络带宽,以提供计算节点所需的最大网络性能。它有一个高速本地缓存,附有 SSD 或超云盘。

- 高性能 NVMe 驱动器可处理 230,000 IOPS,I/O 延迟为 200 𝝻s,并提供 1900 Mbit/s 的读取带宽和 1100 Mbit/s 的写入带宽。

您可以根据需要从不同的购买选项中进行选择,以获取资源并为此付费。

Azure N 系列

Azure N 系列 的 Azure 虚拟机 (VM) 具有 GPU 功能。GPU 是图形和计算密集型工作负载的理想选择,可帮助用户通过深度学习、预测分析和远程可视化等各种场景加速创新。

不同的 N 系列针对特定工作负载提供单独的产品。

- NC 系列专注于高性能机器学习和计算工作负载。最新版本是 NCsv3,它采用 NVIDIA 的 Tesla V100 GPU。

- ND 系列主要关注深度学习的推理和训练场景。它使用 NVIDIA Tesla P40 GPU。最新版本是采用 NVIDIA Tesla V100 GPU 的 NDv2。

- NV 系列专注于由 NVIDIA Tesla M60 GPU 支持的远程可视化和其他密集型应用程序工作负载。

- NC、NCsv3、ND 和 NCsv2 VM 提供 InfiniBand 互连,可实现纵向扩展性能。在这里,您将获得深度学习、图形渲染、视频编辑、游戏等优势。

IBM 云

IBM 云 为您提供灵活性、强大功能和许多 GPU 选项。 由于 GPU 是 CPU 缺乏的额外脑力,IBM Cloud 可帮助您直接访问更易于访问的服务器选择,以便与 IBM Cloud 架构、应用程序和 API 以及全球数据中心的分布式网络无缝集成。

- 您将获得裸机服务器 GPU 选项,例如 Intel Xeon 4210、NVIDIA T4 显卡、20 核、32 GB RAM、2.20 GHz 和 20 TB 带宽。 同样,您还可以选择 Intel Xeon 5218 和 Intel Xeon 6248。

- 对于虚拟服务器,您将获得 AC1.8×60,它具有 8 个 vCPU、60 GB RAM、1 个 P100 GPU。 在这里,您还将获得 AC2.8×60 和 AC2.8×60 的选项。

以每月 819 美元的起价获得裸机服务器 GPU,以每小时 1.95 美元的起价获得虚拟服务器 GPU。

AWS 和 NVIDIA

AWS 和 NVIDIA 一直合作提供具有成本效益、灵活且功能强大的基于 GPU 的解决方案。它包括 NVIDIA GPU 驱动的 Amazon EC2 实例和服务,例如使用 NVIDIA Jetson Nano 模块部署的 AWS IoT Greengrass。

用户将 AWS 和 NVIDIA 用于虚拟工作站、机器学习 (ML)、物联网服务和高性能计算。由 NVIDIA GPU 提供支持的 Amazon EC2 实例负责提供可扩展的性能。此外,使用 AWS IoT Greengrass 将 AWS 云服务扩展到基于 NVIDIA 的边缘设备。

NVIDIA A100 Tensor Core GPU 为 Amazon EC2 P4d 实例提供支持,以提供行业领先的低延迟网络和高吞吐量。同样,您会发现许多其他特定场景的实例,例如 Amazon EC2 P3、Amazon EC2 G4 等。

申请免费试用,体验 GPU 从云端到边缘的强大功能。

OVHcloud

OVHcloud 提供旨在处理大量并行工作负载的云服务器。GPU 有许多与 NVIDIA Tesla V100 图形处理器集成的实例,以满足深度学习和机器学习的需求。

它们有助于加速图形计算领域的计算以及人工智能。 OVH 与 NVIDIA 合作,为高性能计算、人工智能和深度学习提供最佳 GPU 加速平台。

通过完整的目录,使用最直接的方式部署和维护 GPU 加速容器。 它通过 PCI Passthrough 直接向实例提供四张卡中的一张,无需任何虚拟化层来将所有功能专用于您的使用。

OVHcloud 的服务和基础设施已通过 ISO/IEC 27017、27001、27701 和 27018 认证。这些认证表明 OVHcloud 拥有信息安全管理系统 (ISMS) 来管理漏洞、实施业务连续性、管理风险并实施隐私信息管理系统 (PIMS)。

此外,NVIDIA Tesla V100 具有许多有价值的特性,例如 PCIe 32 GB/s、16 GB HBM2 容量、900 GB/s 带宽、双精度 7 teraFLOP、单精度 14 teraFLOP 和深度学习 112 teraFLOP。

Lambda GPU

训练深度学习、机器学习和人工智能模型Lambda GPU 云 只需单击几下,即可从一台机器扩展到虚拟机总数。获取预安装的主要框架和最新版本的 lambda Stack,其中包括 CUDA 驱动程序和深度学习框架。

从仪表板快速访问每台机器的专用 Jupyter Notebook 开发环境。通过其中一个 SSH 密钥直接使用 SSH,或通过云仪表板中的 Web 终端连接以进行直接访问。

每个实例支持最大 10 Gbps 的节点间带宽,可以使用 Horovod 等框架进行分散训练。 您还可以通过扩展到单个或多个实例上的 GPU 数量来节省模型优化时间。

借助 Lambda GPU Cloud,您甚至可以节省 50% 的计算成本,降低云 TCO,并且永远不会获得多年承诺。使用具有 6 个 VCPU、46 GiB RAM、658 GiB 临时存储的单个 RTX 6000 GPU,每小时只需 1.25 美元。 根据您的要求从许多实例中进行选择,以获得供您使用的按需价格。

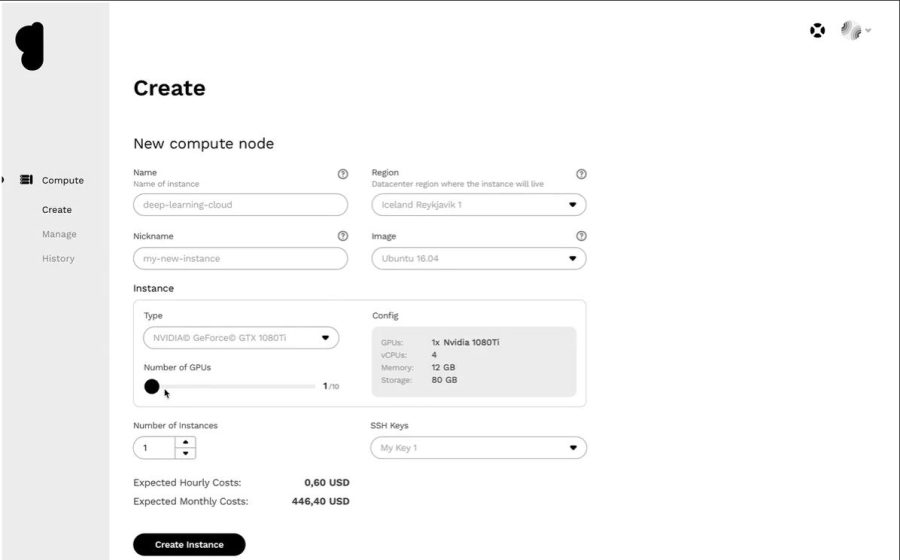

创世纪云

以非常实惠的价格获得高效的云 GPU 平台创世纪云。他们可以访问全球许多高效的数据中心,与他们合作提供广泛的应用程序。

所有服务都是安全的、可扩展的、健壮的和自动化的。Genesis Cloud 为视觉效果、机器学习、转码或存储、大数据分析等提供无限的 GPU 计算能力。

Genesis Cloud 免费提供许多丰富的功能,例如用于保存工作的快照、用于网络流量的安全组、用于大数据集的存储卷、FastAI、PyTorch、预配置图像和 TensorFlow 的公共 API。

它具有不同类型的 NVIDIA 和 AMD GPU。 此外,利用 GPU 计算的力量训练神经网络或生成动画电影。 他们的数据中心使用来自地热资源的 100% 可再生能源运行,以降低碳排放。

他们的定价比其他提供商低 85%,因为您需要为分钟级的增量付费。 您还可以通过长期和抢占式折扣节省更多。

结论👩🏫

云 GPU 旨在提供卓越的性能、速度、可扩展性、空间和便利性。因此,请考虑选择具有开箱即用功能的首选云 GPU 平台,以加速您的深度学习模型并轻松处理 AI 工作负载。