提升SEO的必备工具:免费网络爬虫软件

您是否渴望提升网站的搜索引擎排名、增加曝光率并提高转化率?为了实现这些目标,您需要一款强大的网络爬虫工具。网络爬虫是一种自动浏览互联网的计算机程序,也被称为网络蜘蛛或蜘蛛机器人。它们能够高效地扫描网页,并提取有价值的信息。网络数据提取软件和网站抓取程序都是网络爬虫技术的应用实例。今天,我们将探索一些可免费下载的网络爬虫工具,这些工具将助力您的SEO策略。

精选25款免费网络爬虫工具

网络爬虫工具为数据挖掘和分析提供了丰富的资源。其主要功能是对互联网上的网页进行索引。它们能有效检测断开的链接、重复内容、缺失的页面标题,并识别严重的SEO问题。通过抓取在线数据,您的业务将从中获益良多。

- 有些网络爬虫应用能够精确地从任何网站URL抓取数据。

- 这些程序有助于优化网站结构,使搜索引擎更好地理解您的网站,从而提高排名。

为了方便您的选择,我们精心编制了一份免费网络爬虫工具清单,其中详细列出了它们的功能和成本。这份列表还包括了值得您关注的付费选项。

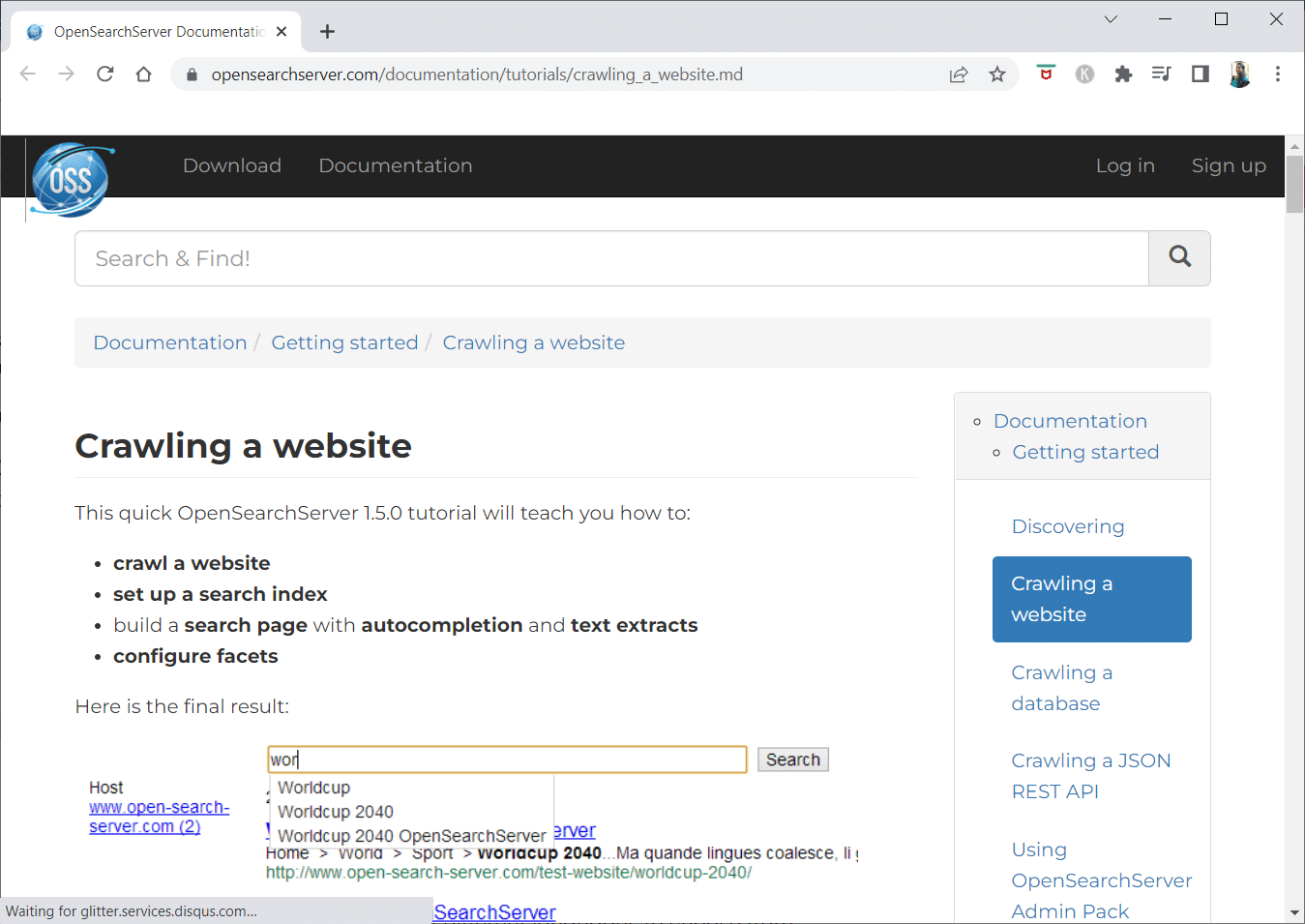

1. OpenSearchServer

OpenSearchServer是一款广受好评的免费网络爬虫,是您在互联网上能找到的强大替代方案之一。

- 它是一个完全集成的解决方案。

- OpenSearchServer是一款免费的开源网络爬虫和搜索引擎。

- 它提供一站式且经济高效的解决方案。

- 它拥有全面的搜索功能,允许您构建个性化的索引策略。

- 该爬虫几乎可以索引任何类型的内容。

- 提供全文搜索、布尔搜索和语音搜索等多种选项。

- 支持17种不同的语言。

- 具备自动分类功能。

- 您可以为频繁发生的任务设置时间表。

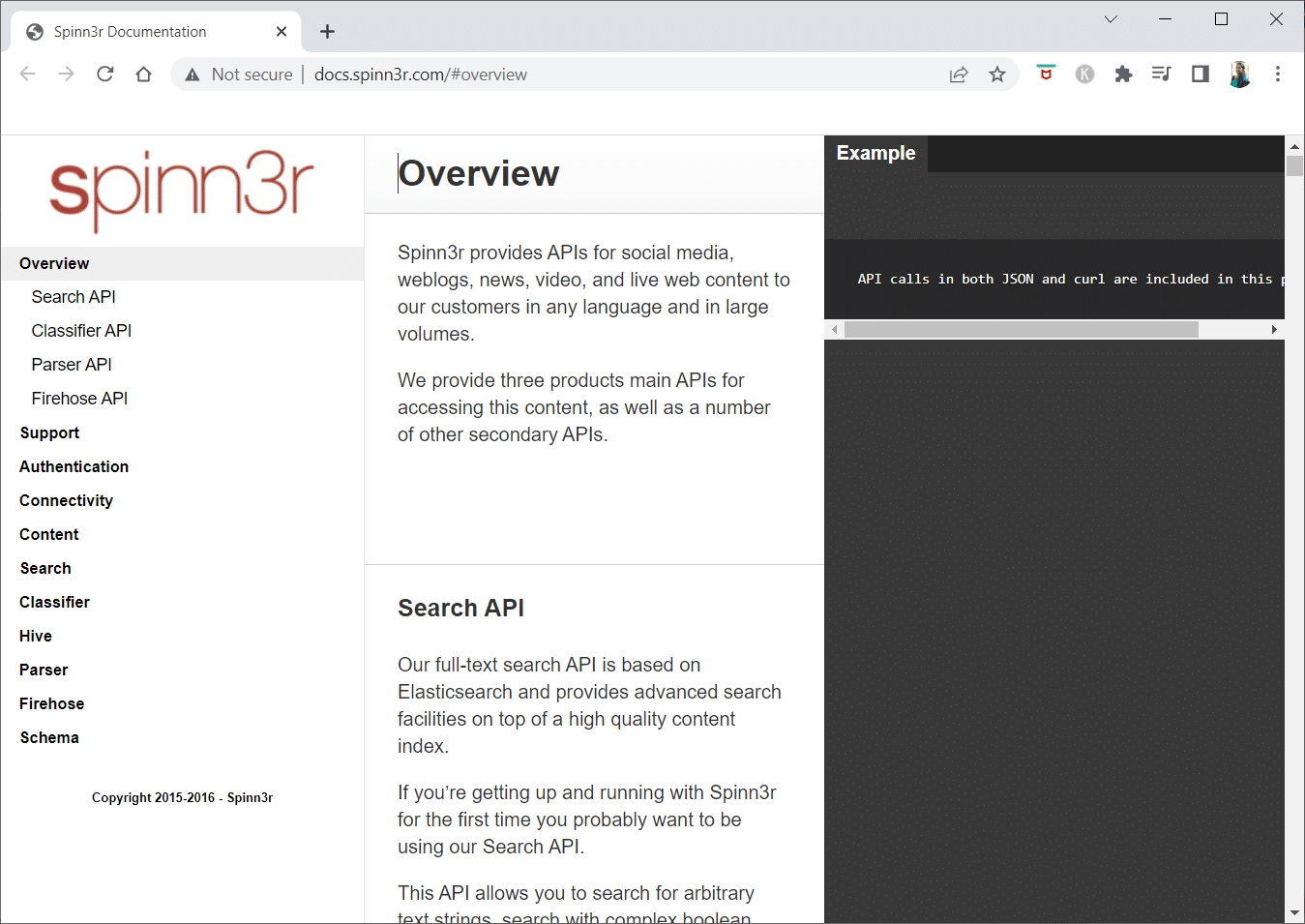

2. Spinn3r

Spinn3r网络爬虫程序能够全面提取来自博客、新闻网站、社交媒体、RSS feed以及ATOM feed的内容。

- 它配备了高速API,可以处理高达95%的索引工作。

- 此网络爬虫应用包含高级垃圾邮件防护功能,可清除垃圾邮件和不当言论,从而提高数据安全性。

- Spinn3r持续在网络上搜索来自各种来源的更新,为您提供实时内容。

- 它以与Google相似的方式索引内容,并将提取的数据保存为JSON文件。

- Parser API允许您快速解析和管理任意Web URL的信息。

- Firehose API专为大规模访问海量数据而设计。

- 简单的HTTP标头用于验证Spinn3r的所有API。

- 这是一个可免费下载的网络爬虫工具。

- 分类器API允许开发人员传输文本(或URL),由机器学习技术进行标记。

3. Import.io

Import.io允许您在几分钟内抓取数百万个网页,并根据您的需求构建1000多个API,无需编写任何代码。

- 它现在可以通过编程方式操作,并且可以自动检索数据。

- 只需单击按钮,即可从多个页面中提取数据。

- 它可以自动识别分页列表,并能够点击下一页。

- 只需几步操作,您就可以将在线数据整合到您的应用程序或网站中。

- 通过使用页码和类别名称等模式,在几秒钟内创建所需的全部URL。

- Import.io可以直观地演示如何从页面中提取数据。只需从数据集中选择一列,然后指向页面上您感兴趣的内容即可。

- 您可以直接在其网站上获取报价。

- 列表页面中的链接指向包含更多详细信息的页面。

- 您可以利用Import.io来一次性获取所有详细信息页面中的数据。

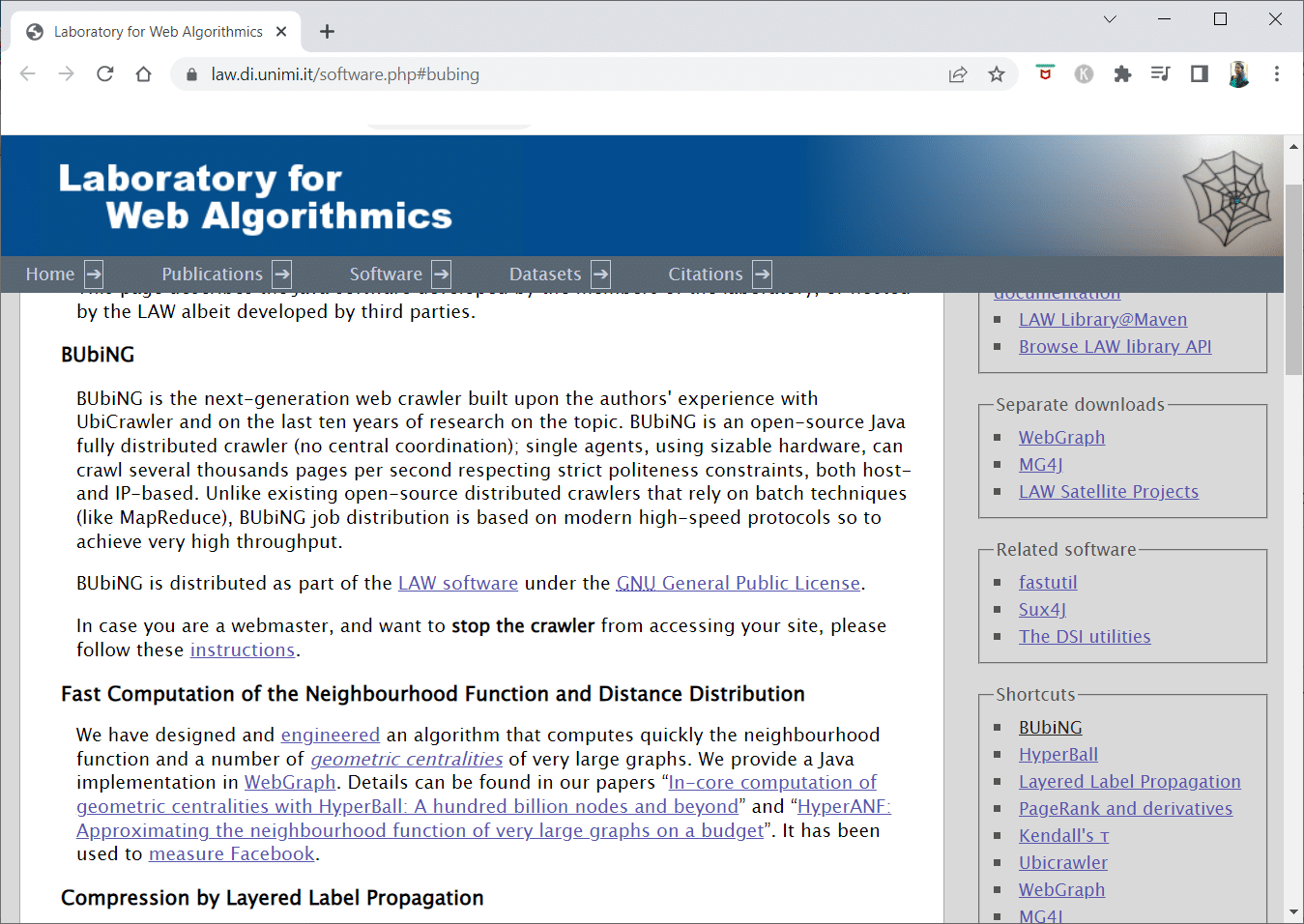

4. BUBIING

BUbiNG是下一代网络爬虫工具,凝聚了作者在使用UbiCrawler的经验以及对该主题十年的深入研究。

- 单个代理每秒可以抓取数千页,同时严格遵守主机和基于IP的礼貌标准。

- 其作业分配基于现代高速协议,提供极高的吞吐量,这与早期依赖批处理技术的开源分布式爬虫截然不同。

- 它使用剥离页面的指纹来检测近似重复。

- BUbiNG是一个完全分布式的开源Java爬虫。

- 具有高度的并行处理能力。

- 拥有广泛的用户群体。

- 速度极快。

- 能够实现大规模爬取。

5. GNU Wget

GNU Wget是一个免费下载的网络爬虫工具,它是一个用C语言编写的开源软件程序,允许您通过HTTP、HTTPS、FTP和FTPS获取文件。

- 此应用最独特的特性之一是能够使用多种语言创建基于NLS的消息文件。

- 您可以利用REST和RANGE重新启动已停止的下载。

- 如果需要,它还可以将下载文档中的绝对链接转换为相对链接。

- 在文件名和镜像目录中递归使用通配符。

- 支持多种基于NLS的消息文件。

- 在镜像时,会对本地文件时间戳进行评估,以确定是否需要重新下载文档。

6. Webhose.io

Webhose.io是一款优秀的网络爬虫应用,允许您使用跨越各种来源的过滤器扫描数据,并提取多种语言的关键字。

- 该存档还允许用户查看过往数据。

- 此外,webhose.io的爬取数据发现支持多达80种语言。

- 所有泄露的个人身份信息都可以在同一位置找到。

- 调查暗网和消息传递应用中是否存在网络威胁。

- XML、JSON和RSS格式也可用于抓取的数据。

- 您可以直接在其网站上获取报价。

- 用户可以简单地索引和搜索Webhose.io上的结构化数据。

- 它可以监控和分析所有语言的媒体渠道。

- 可以跟踪留言板和论坛上的讨论。

- 它允许您跟踪来自网络各地的关键博客文章。

7. Norconex

Norconex是寻找开源网络爬虫应用的企业的理想选择。

- 这个功能全面的收集器可以单独使用或集成到您的程序中。

- 它还可以抓取页面的特色图像。

- Norconex使您能够抓取任何网站的内容。

- 可以在任何操作系统上运行。

- 该网络爬虫软件可以在单个平均容量的服务器上爬取数百万个页面。

- 它还包括一组用于修改内容和元数据的工具。

- 获取当前正在处理的文档的元数据。

- 支持JavaScript呈现的页面。

- 它可以检测多种语言。

- 提供翻译支持。

- 您可以调整爬取速度。

- 可以识别已修改或删除的文档。

- 这是一个完全免费的网络爬虫程序。

8. Dexi.io

Dexi.io是一款基于浏览器的网络爬虫应用,允许您从任何网站抓取信息。

- 提取器、爬虫和管道是您可用于抓取操作的三种机器人。

- 使用Delta报告预测市场发展趋势。

- 您收集的数据将在Dexi.io的服务器上保存两周后存档,或者您可以立即将提取的数据导出为JSON或CSV文件。

- 您可以直接在其网站上获取报价。

- 提供专业服务,如质量保证和持续维护。

- 提供商业服务,以满足您的实时数据需求。

- 可以追踪无限数量的SKU/产品的库存和定价。

- 它允许您使用实时仪表板和全面的产品分析来集成数据。

- 它可以帮助您准备和清洗基于Web的结构化且可随时使用的产品数据。

9. Zyte

Zyte是一款基于云的数据提取工具,可帮助数以万计的开发人员定位关键信息。它也是最出色的免费网络爬虫应用之一。

- 用户可以在不懂任何编码的情况下,使用其开源可视化抓取应用来抓取网页。

- Crawlera是Zyte使用的复杂代理旋转器,允许用户轻松爬取大型或受机器人保护的网站,同时规避机器人对策。

- 您的在线信息会按时并持续交付。因此,您可以专注于获取数据,而无需管理代理。

- 由于智能浏览器功能和渲染技术,现在可以轻松管理针对浏览器层的反机器人措施。

- 您可以直接在其网站上获取报价。

- 用户可以使用简单的HTTP API,从多个IP和区域进行爬取,无需代理维护。

- 它可以帮助您通过获取所需的信息来节省时间和产生收入。

- 它允许您大规模提取Web数据,同时节省编码和蜘蛛维护时间。

10. Apache Nutch

Apache Nutch无疑是开源网络爬虫应用列表中的佼佼者。

- 它可以在一台机器上运行,但在Hadoop集群上表现最佳。

- 采用NTLM协议进行身份验证。

- 它具有一个分布式文件系统(通过Hadoop)。

- 它是一个著名的开源在线数据提取软件项目,具有适应性和可扩展性,可用于数据挖掘。

- 全球许多数据分析师、科学家、应用开发人员和网络文本挖掘专家都在使用它。

- 这是一个基于Java的跨平台解决方案。

- 默认情况下,抓取和解析操作是独立进行的。

- 使用XPath和命名空间映射数据。

- 它包含一个链接图数据库。

11. VisualScraper

VisualScraper是另一款出色的无代码网络爬虫,用于从互联网中提取数据。

- 它提供了一个简洁的点击式用户界面。

- 它还提供在线抓取服务,例如数据传播和软件提取器的构建。

- 它密切关注您的竞争对手。

- 用户可以安排他们的项目在特定时间运行,或者使用Visual Scraper每隔一分钟、一天、一周、一个月和一年重复该序列。

- 它不仅更经济,而且更高效。

- 不需要编程技能。

- 这是一个完全免费的网络爬虫程序。

- 实时数据可以从多个网页中提取并保存为CSV、XML、JSON或SQL文件。

- 用户可以使用它来定期提取新闻、更新和论坛帖子。

- 数据100%准确且可定制。

12. WebSphinx

WebSphinx是一款出色的个人免费网络爬虫应用,易于设置和使用。

- 它专为希望自动扫描互联网有限部分的复杂网络用户和Java程序员而设计。

- 这个在线数据提取解决方案包括一个Java类库和一个交互式编程环境。

- 页面可以连接起来形成一个可以浏览或打印的文档。

- 从一系列页面中提取符合特定模式的所有文本。

- 得益于此工具包,现在可以使用Java编写网络爬虫。

- WebSphinx中包含Crawler Workbench和WebSPHINX类库。

- Crawler Workbench是一个图形用户界面,允许您自定义和操作网络爬虫。

- 一个图表可以由一组网页组成。

- 将页面保存到本地驱动器以便离线阅读。

13. OutWit Hub

OutWit Hub平台由一个核心组成,该核心具有广泛的数据识别和提取功能库,可以在其上创建无数不同的应用程序,每个应用程序都利用核心的功能。

- 此网络爬虫应用可以扫描站点并以可访问的方式保存其发现的数据。

- 它是一款多功能的收割机,尽可能多地满足各种需求。

- Hub已经存在很长时间了。

- 对于懂得编码但认为PHP并非总是提取数据的理想选择的非技术用户和IT专业人员来说,它已经发展成为一个有用且多功能的平台。

- OutWit Hub提供一个单一界面,可根据您的需求抓取适量或大量的数据。

- 它使您能够直接从浏览器中抓取任何网页,并构建自动化代理以抓取数据并根据您的要求进行处理。

- 您可以直接在其网站上获取报价。

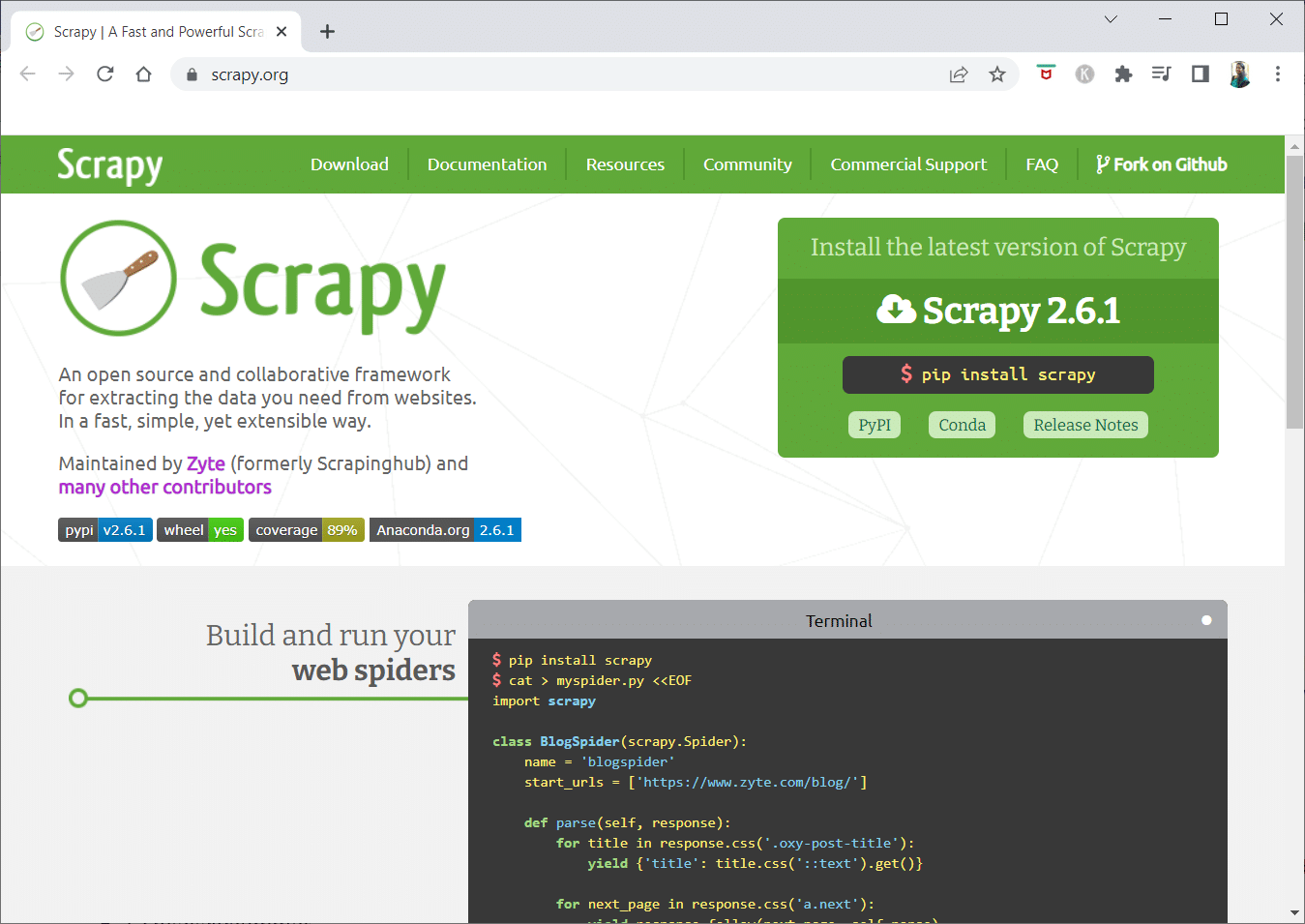

14. Scrapy

Scrapy是一个Python在线抓取框架,用于构建可扩展的网络爬虫。

- 它是一个完整的网络爬虫框架,可以处理使网络爬虫难以构建的各种功能,如代理中间件和查询问题。

- 您可以编写提取数据的规则,然后让Scrapy处理其余部分。

- 由于它的设计特点,无需修改核心即可轻松添加新功能。

- 它是一个基于Python的程序,可在Linux、Windows、Mac OS X和BSD系统上运行。

- 这是一个完全免费的实用程序。

- 它的库为程序员提供了一个现成的结构,用于自定义网络爬虫并从网络中大规模提取数据。

15. Mozenda

Mozenda也是最好的免费网络爬虫应用之一。它是一款面向企业的基于云的自助式网页抓取程序。 Mozenda已经抓取了超过70亿页,在全球拥有众多企业客户。

- Mozenda的网络抓取技术消除了对脚本编写和雇用工程师的需求。

- 它将数据收集速度提高了五倍。

- 您可以使用Mozenda的点击功能从网站上抓取文本、文件、图像和PDF信息。

- 通过组织数据文件,您可以为发布做好准备。

- 您可以使用Mozenda的API直接导出到TSV、CSV、XML、XLSX或JSON。

- 您可以使用Mozenda复杂的数据整理功能来组织您的信息,以便您做出重要的决策。

- 您可以利用Mozenda合作伙伴的平台之一来集成数据,或在多个平台中建立自定义数据集成。

16. Cyotek WebCopy

Cyotek WebCopy是一款免费的网络爬虫工具,可让您自动将网站内容下载到本地设备。

- 所选网站的内容将被扫描和下载。

- 您可以选择要克隆网站的哪些部分以及如何使用其复杂的结构。

- 新的本地路由会将链接重定向到样式表、图片和其他页面等网站资源。

- 它将查看网站的HTML标记,并尝试查找任何连接的资源,例如其他网站、照片、视频、文件下载等。

- 它可能会抓取网站并下载其所看到的一切,以制作一个可接受的原始副本。

17. Common Crawl

Common Crawl适用于任何有兴趣探索和分析数据以获取有用见解的人。

- 这是一家501(c)(3)非营利组织,依靠捐款来维持运营。

- 任何希望使用Common Crawl的人都可以在不花任何费用或造成问题的情况下这样做。

- Common Crawl是一个可用于教学、研究和分析的语料库。

- 如果您没有任何技术技能来理解其他人利用Common Crawl数据取得的非凡发现,您应该阅读相关文章。

- 教师可以使用这些工具来教授数据分析。

18. Semrush

Semrush是一款网站爬虫应用,可检查您网站的页面和结构是否存在技术SEO问题。解决这些问题可以帮助您提高搜索结果排名。

- 它具有用于搜索引擎优化、市场研究、社交媒体营销和广告的工具。

- 它拥有用户友好的界面。

- 将检查元数据、HTTP/HTTPS、指令、状态代码、重复内容、页面响应速度、内部链接、图像大小、结构化数据和其他元素。

- 它可以让您快速轻松地审核您的网站。

- 它有助于分析日志文件。

- 该程序提供了一个仪表板,使您可以轻松查看网站问题。

19. Sitechecker.pro

Sitechecker.pro是另一款出色的免费网络爬虫应用。它是一款网站的SEO检查器,可帮助您提高SEO排名。

- 您可以轻松地可视化网页的结构。

- 它会生成一份关于页面SEO审核的报告,客户可以通过电子邮件接收。

- 这个网络爬虫工具可以查看您网站的内部和外部链接。

- 它可以帮助您确定网站的速度。

- 您还可以使用Sitechecker.pro检查登录页面的索引问题。

- 它可以帮助您防御黑客攻击。

20. WebHarvy

WebHarvy是一款网页抓取工具,具有简单的点击式界面。它专为那些不熟悉编程的人设计。

- 许可证的起价为139美元。

- 您可以使用WebHarvy的内置浏览器加载在线站点,并使用鼠标单击选择要抓取的数据。

- 它可以自动从网站上抓取文本、照片、URL和电子邮件,并以各种格式保存。

- 代理服务器或VPN可用于访问目标网站。

- 抓取数据不需要创建任何程序或应用程序。

- 通过使用代理服务器或VPN访问目标网站,可以匿名抓取并防止网页抓取软件被网络服务器禁止。

- WebHarvy会自动识别网站中的数据模式。

- 如果您需要从网页中抓取对象列表,则无需执行任何其他操作。

21. NetSpeak Spider

NetSpeak Spider是一款桌面网络爬虫应用,适用于日常SEO审计,快速查找问题,进行系统分析,以及抓取网页。

- 此网络爬虫应用擅长评估大型网页,同时最大程度地减少RAM的使用。

- 可以轻松地从网络爬取数据中导入和导出CSV文件。

- 只需点击几下,您就可以识别数百个其他严重的网站SEO问题。

- 该工具将帮助您评估网站的页面优化情况,包括状态代码、抓取和索引说明、网站结构和重定向等。

- 可以导出来自Google Analytics和Yandex的数据。

- 为您的网站页面、流量、转化、目标,甚至电子商务设置考虑数据范围、设备类型和细分。

- 其月度订阅起价为21美元。

- SEO爬虫将检测到损坏的链接和照片,以及重复的材料,例如页面、文本、重复的标题和元描述标签以及H1。

22. UiPath

UiPath是一款网络爬虫在线抓取工具,允许您自动化机器人程序。它可以自动抓取来自大多数第三方程序的在线和桌面数据。

- 您可以在Windows上安装机器人过程自动化应用。

- 它可以从多个网页中以表格和基于模式的形式提取数据。

- UiPath可以直接进行额外的抓取。

- 报告会追踪您的机器人,以便您随时参考文档。

- 如果您标准化您的实践,您的结果将更加有效和成功。

- 每月订阅起价为420美元。

- Marketplace的200多个现成组件为您的团队提供更多时间和更少的操作。

- UiPath机器人通过遵循满足您需求的确切方法来提高合规性。

- 公司可以通过优化流程、认识经济效益和提供深刻见解,以更低的成本实现快速的数字化转型。

23. Helium Scraper

Helium Scraper是一款可视化在线数据网络爬取应用,当元素之间几乎没有关联时效果最佳。基本可以满足用户的爬取需求。

- 它不需要任何编码或配置。

- 清晰简单的用户界面允许您从指定列表中选择和添加活动。

- 在线模板也可用于特定的爬取要求。

- 在后台,使用了多个Chromium网络浏览器。

- 增加同时浏览器的数量以获取尽可能多的数据。

- 定义您自己的操作,或使用自定义JavaScript进行更复杂的操作。

- 它可以安装在个人计算机或专用Windows服务器上。

- 其许可证起价为99美元,并由此逐渐上涨。

24. 80legs

80Legs成立于2009年,旨在让在线数据更容易获取。它也是最好的免费网络爬虫工具之一。 最初,该公司专注于为各种客户提供网络爬虫服务。

- 我们广泛的网络爬虫应用将为您提供个性化信息。

- 爬取速度会根据网站流量自动调整。

- 您可以通过80legs将抓取结果下载到本地环境或计算机。

- 只需提供一个URL,您就可以开始抓取该网站。

- 其月度订阅起价为每月29美元。

- 借助SaaS,可以构建和进行网络爬虫。

- 它拥有众多服务器,允许您从各种IP地址查看站点。

- 获得对站点数据的即时访问,而不是在网络上搜索。

- 它有助于定制网络爬虫的构建和执行。

- 您可以使用此应用来跟踪在线趋势。

- 如果需要,您可以创建自己的模板。

25. ParseHub

ParseHub是一款出色的网络爬虫应用,可以从使用AJAX、JavaScript、cookie和其他相关技术的网站收集信息。

- 它的机器学习引擎可以读取、评估在线内容并将其转换为有意义的数据。

- 您还可以使用浏览器中的内置网络应用。

- 可以从数以百万计的网站获取信息。

- ParseHub将自动搜索数千个链接和单词。

- 数据会自动收集并存储在我们的服务器上。

- 每月套餐起价为149美元。

- 作为共享软件,您只能在ParseHub上构建五个公共项目。

- 您可以使用它来访问下拉菜单、登录网站、点击地图以及使用无限滚动、选项卡和弹出窗口管理网页。

- ParseHub的桌面客户端可用于Windows、Mac OS X和Linux。

- 您可以获取任何格式的抓取数据以进行分析。

- 您可以建立至少20个具有高级会员级别的私人抓取项目。

***

我们希望本文对您有所帮助,并能帮助您选择一款适合您需求的免费网络爬虫工具。请在下面的评论部分分享您的想法、疑问和建议。此外,您还可以向我们推荐任何遗漏的工具。请告诉我们您接下来希望学习的内容。