数据整理:从混乱到洞察

在当今的互联网时代,我们正经历着数据量呈指数级增长,从 TB 级到 PB 级不等。面对如此庞大的数据海洋,如何有效地利用它们,将其转化为有价值的信息,以提升服务质量,成为了一个关键挑战。

企业知识发现模型的核心在于有效、新颖且易于理解的数据。为了达成这一目标,企业正积极探索各种数据分析方法,以期挖掘出高质量的数据。

而这一切的起点,正是数据整理。

让我们深入了解一下数据整理的奥秘吧!

什么是数据整理?

数据整理,顾名思义,指的是对原始数据进行清洗、结构化以及转换为易于数据分析的格式的过程。 这通常涉及到处理那些尚未为数据管道流程做好准备的、杂乱无章且复杂的数据集。数据整理的目的在于将原始数据转化为精炼状态,或者进一步优化至生产就绪的级别。

数据整理中常见的一些任务包括:

- 将多个数据集整合为一个大型数据集,以便进行分析。

- 检查数据中是否存在缺失或空白。

- 移除数据集中的异常值或异常数据。

- 标准化数据输入。

由于数据整理过程中涉及的数据量通常非常庞大,超出人工处理的能力范围,因此需要借助自动化数据准备方法,以生成更准确、质量更高的数据。

数据整理的目标

除了为分析准备数据这一主要目标外,数据整理还具有以下目标:

- 从杂乱的数据中提取有效且有价值的数据,从而推动企业的决策过程。

- 将原始数据标准化为大数据系统可以接受的格式。

- 通过呈现有序的数据,减少数据分析师在构建数据模型时所花费的时间。

- 确保在数据仓库中使用或存储的任何数据集都具有一致性、完整性、可用性和安全性。

数据整理的常用方法

发现

在数据工程师开始数据准备工作之前,他们需要充分了解数据的存储方式、大小、记录数量、编码格式以及其他描述数据集的属性。

结构化

此过程涉及整理数据,使其呈现易于使用的格式。原始数据集可能需要对列的显示方式、行数以及其他数据属性进行调整,以简化后续的分析。

清理

结构化的数据集需要清除其固有的错误以及任何可能扭曲数据的信息。清理工作包括删除重复的单元格条目、删除空单元格和异常数据、标准化数据输入以及重命名不明确的属性等。

丰富

当数据经过结构化和清理阶段后,有必要评估数据的效用,并使用来自其他数据集的值进行增强。 这有助于提升数据质量,使其能更好地满足分析需求。

验证

验证过程需要迭代编程,以确保数据质量、一致性、可用性和安全性。验证阶段旨在确保所有转换任务都已完成,并将数据集标记为可以进行分析和建模。

呈现

当所有阶段都完成后,经过整理的数据集将在组织内部进行呈现和共享,以用于分析。同时,还会共享整理过程中产生的准备步骤和元数据文档。

Talend

Talend 是一个统一的数据管理平台,包含在 3 个数据结构中,旨在提供可靠和健康的数据。Talend 涵盖了数据集成、应用程序和集成以及数据完整性和治理。在 Talend 中,数据整理通过基于浏览器的点击式工具实现,该工具支持批量、分批和实时数据准备,包括数据分析、清理和文档。

Talend Data Fabric 处理数据生命周期的每个阶段,确保数据可用性、可访问性、安全性和完整性之间达到平衡。

是否曾为多样化的数据源而感到担忧? Talend 的统一方法提供了来自各种数据源(如数据库、云存储和 API 端点)的快速数据集成,从而实现对所有数据的无缝质量检查、转换和映射。

Talend 中的数据集成是通过连接器等自助服务工具实现的,这些工具允许开发人员自动从任何来源获取数据,并对数据进行充分分类。

Talend 的特点

通用数据集成

Talend 允许企业处理来自各种数据源(无论是云端还是本地环境)的任何数据类型。

灵活性

在构建数据管道时,Talend 不受供应商或平台的限制。一旦从摄取的数据创建了数据管道,Talend 允许您在任何地方运行该管道。

数据质量

借助重复数据删除、验证和标准化等机器学习功能,Talend 可以自动清理摄取的数据。

支持应用程序和 API 集成

在通过 Talend 自助服务工具从数据中获取有意义的信息后,您可以通过用户友好的 API 共享您的数据。 Talend API 端点可以通过高级数据映射和转换工具将您的数据资产暴露给 SaaS、JSON、AVRO 和 B2B 平台。

R

R 是一种成熟且有效的编程语言,适用于科学和商业应用程序的探索性数据分析。

作为一款免费的统计计算和图形软件,R 既是一种用于数据整理、建模和可视化的语言,也是一个环境。R 环境提供了一系列软件包,而 R 语言集成了有助于操作数据的统计、聚类、分类、分析和图形技术。

R 的特点

丰富的软件包

数据工程师可以从综合 R 存档网络 (CRAN) 中选择超过 10,000 个标准化的软件包和扩展,这简化了数据整理和分析过程。

强大的功能

借助可用的分布式计算软件包,R 可以在几秒钟内对数据对象和数据集执行复杂的数学和统计操作。

跨平台支持

R 与平台无关,可以在多种操作系统上运行。 它还与其他有助于处理计算密集型任务的编程语言兼容。

R 的学习曲线相对平缓,易于上手。

Trifacta

Trifacta 是一个交互式的云环境,用于分析为机器学习和分析模型运行的数据。该数据工程工具旨在创建易于理解的数据,无论数据集多么混乱或复杂。用户可以通过重复数据删除和线性转换来删除重复条目,并填充数据集中的空白单元格。

这个数据整理工具可以发现任何数据集中的异常值和无效数据。只需点击和拖动,就可以利用机器学习支持的建议对数据进行排序和智能转换,从而加速数据准备过程。

Trifacta 中的数据整理是通过引人注目的可视化配置文件进行的,该配置文件可以为技术和非技术人员所用。凭借其可视化和智能转换功能,Trifacta 以其以用户为中心的设计而著称。

无论数据来自数据集市、数据仓库还是数据湖,用户都可以避免数据准备的复杂性。

Trifacta 的特点

无缝云集成

Trifacta 支持跨任何云或混合环境进行准备工作,允许开发人员摄取数据集进行整理,而无需考虑其数据存储位置。

多种数据标准化方法

Trifacta Wrangler 提供了多种机制来识别数据模式并标准化输出。数据工程师可以选择按模式、按函数或混合方式进行标准化。

简单的工作流程

Trifacta 以流的形式组织数据准备工作。一个流包含一个或多个数据集以及与其相关的配方(用于转换数据的定义步骤)。

因此,流减少了开发人员在导入、整理、分析和导出数据时所花费的时间。

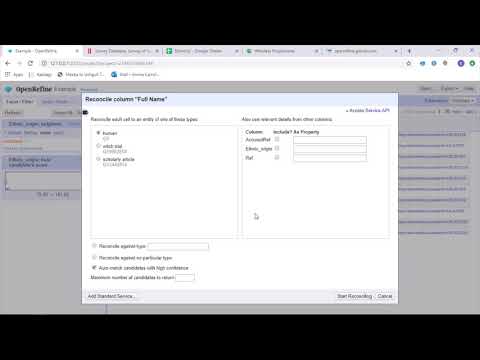

OpenRefine

OpenRefine 是一款成熟的开源工具,用于处理杂乱的数据。作为一款数据清理工具,OpenRefine 可以在几秒钟内探索数据集,同时应用复杂的单元格转换,从而呈现所需的数据格式。

OpenRefine 使用正则表达式,通过数据集上的过滤器和分区来处理数据。借助内置的通用优化表达式语言,数据工程师可以使用切面、过滤器和排序技术来学习和查看数据,然后再执行高级数据操作(例如实体提取)。

OpenRefine 允许用户将数据作为项目处理,其中可以将来自多个计算机文件、Web URL 和数据库的数据集导入到项目中,并在用户的计算机上本地运行。

通过表达式,开发人员可以将数据清理和转换扩展到诸如拆分/连接多值单元格、自定义切面以及使用外部 URL 将数据提取到列中等任务。

OpenRefine 的特点

跨平台工具

OpenRefine 可通过下载安装程序,在 Windows、Mac 和 Linux 操作系统上使用。

丰富的 API

OpenRefine 提供了多个 API,包括 OpenRefine API、数据扩展 API 和对账 API,以支持用户与数据进行交互。

Datameer

Datameer 是一种 SaaS 数据转换工具,旨在通过软件工程流程简化数据处理和集成。Datameer 支持将数据集提取、转换和加载到云数据仓库,例如 Snowflake。

该数据整理工具适用于 CSV 和 JSON 等标准数据集格式,允许工程师以各种格式导入数据进行聚合。

Datameer 具有类似目录的数据文档、深度数据分析和发现功能,可以满足所有数据转换需求。该工具保留了深入的可视化数据配置文件,允许用户跟踪无效、缺失或异常的字段和值,以及数据的整体形状。

Datameer 在可扩展的数据仓库上运行,通过高效的数据堆栈和类似于 Excel 的函数转换数据,以进行有意义的分析。

Datameer 提供了混合、代码和无代码用户界面,以适应能够轻松构建复杂 ETL 管道的各种数据分析团队。

Datameer 的特点

多用户环境

Datameer 提供多人数据转换环境,包括低代码、代码和混合模式,以支持技术和非技术人员。

共享工作区

Datameer 允许团队重用和协作模型,以加快项目速度。

丰富的数据文档

Datameer 通过元数据和 wiki 风格的描述、标签和评论,支持系统和用户生成的数据文档。

总结

数据分析是一个复杂的过程,需要适当组织数据才能得出有意义的结论和做出预测。数据整理工具可以帮助您格式化大量的原始数据,从而支持您执行高级分析。选择最符合您需求的工具,并成为一名数据分析专家!

你可能还喜欢:

用于转换、格式化和验证的最佳 CSV 工具。