对于那些不熟悉编程的人来说,构建一个网络爬虫可能颇具挑战。值得庆幸的是,现在有许多网络数据抓取工具,无论是程序员还是非程序员都能轻松使用。这些软件的设计初衷就是为了从网站上提取有价值的数据。对于任何想要以某种方式从互联网获取数据的人来说,这些工具都非常实用。获取到的信息会被保存到计算机的本地文件或数据库中。简而言之,它是一种自动从网络搜集数据的技术。下面,我们精心挑选了31款最佳的免费网络抓取工具。

31款卓越的网络数据抓取工具

这里汇集了一份精心挑选的优秀网络抓取工具列表。此列表囊括了商业和开源工具,并提供了指向各自官方网站的链接。

1. Outwit

Outwit是一款火狐浏览器的插件,可以轻松地从火狐插件商店安装。

- 这款数据抓取工具使得从网络和电子邮件中收集联系方式变得轻而易举。

- 根据您的需求,您可以选择购买此产品的三个版本:

- 专业版

- 专家版

- 企业版

- 使用Outwit Hub从网站提取精确数据无需任何编程知识。

- 只需点击浏览按钮,即可开始抓取成百上千的网页。

2. ParseHub

ParseHub是另一个优秀的免费网络抓取工具。

- 在下载数据之前,它可以清理文本和HTML。

- 使用其强大的网络抓取工具,选择需要提取的数据非常简单。

- 它被誉为最好的数据抓取工具之一,因为它允许您以任何格式存储抓取的数据,以便后续进行分析。

- 具有用户友好的图形界面。

- 这款互联网抓取工具允许您自动收集数据并将其保存在服务器上。

3. Apify

Apify是另一款出色的网络抓取和自动化工具,它允许您为任何网站构建API。它内置住宅和数据中心代理,让数据提取更加便捷。

- Apify负责基础设施和计费,让开发者可以通过为他人设计工具来赚取被动收入。

- 一些可用的连接器包括Zapier、Integromat、Keboola和Airbyte。

- Apify商店为Instagram、Facebook、Twitter和谷歌地图等流行网站提供了现成的抓取解决方案。

- JSON、XML、CSV、HTML和Excel都是可供下载的结构化格式。

- Apify代理具有HTTPS、地理位置定位、智能IP轮换和Google SERP代理等功能。

- 提供30天免费试用,并赠送5美元的平台信用。

4. Scrapestack

Scrapestack被超过2000家公司所使用,他们依赖于apilayer提供的这款独特的API。它是最优秀的免费网络抓取工具之一。

- 它利用一个由3500万个数据中心组成的全球IP地址池。

- 允许一次执行多个API请求。

- 支持CAPTCHA解密和JavaScript渲染。

- 提供免费和付费选项。

- Scrapestack是一个实时运行的在线抓取REST API。

- Scrapestack API允许您使用数百万个代理IP、浏览器和验证码在几毫秒内抓取网页。

- 网络抓取请求可以从全球100多个不同的位置发送。

5. FMiner

FMiner是一款适用于Windows和Mac OS的流行在线抓取、数据提取、屏幕抓取、宏和网络支持程序。

- 它可以从难以抓取的动态Web 2.0网站上收集数据。

- 允许您使用易于使用的可视化编辑器创建数据提取项目。

- 结合使用链接结构、下拉菜单和URL模式匹配,让您深入浏览网页。

- 您可以使用第三方自动验证码服务或手动输入目标网站的验证码保护。

6. Sequentum

Sequentum是一款强大的大数据工具,用于获取可靠的在线数据。它是另一款优秀的免费网络抓取工具。

- 与其他解决方案相比,提取在线数据的速度更快。

- 您可以使用此功能在多个平台之间进行转换。

- 它是用于发展您的公司最强大的网络抓取工具之一。它包含简单的功能,包括可视化的点击式编辑器。

- 专用的Web API将允许您直接从您的网站执行Web数据,从而帮助您开发Web应用程序。

7. Agenty

Agenty是一个使用机器人流程自动化的数据抓取、文本提取和OCR程序。

- 该程序使您能够将所有处理过的数据重新用于分析目的。

- 只需点击几下鼠标,即可构建代理。

- 作业完成后,您将收到一封电子邮件。

- 它允许您连接到Dropbox并使用安全的FTP。

- 可以查看所有事件的所有活动日志。

- 帮助您提高公司的成功率。

- 让您轻松实现业务规则和自定义逻辑。

8. import.io

通过从某个网页导入数据并将数据导出为CSV,import.io网络抓取应用程序可帮助您形成数据集。它也是最好的网络抓取工具之一。以下是此工具的功能。

- Web表单/登录名易于使用。

- 它是利用API和webhook将数据集成到应用程序中的最佳数据抓取解决方案之一。

- 您可以通过报告、图表和可视化获得洞察力。

- 应提前计划数据提取。

- Import.io云允许您存储和访问数据。

- 与网络和工作流程的交互可以自动化。

9. Webz.io

Webz.io允许您抓取数百个网站,并立即访问结构化和实时数据。它也是最优秀的免费网络抓取工具之一。

您可以获得JSON和XML格式的有组织的、机器可读的数据集。

- 它使您可以访问跨越十年数据的历史提要。

- 允许您访问大型数据馈送数据库,而无需支付任何额外费用。

- 您可以使用高级过滤器进行详细分析并提供数据集。

10. Scrape Owl

Scrape Owl是一个易于使用且经济实惠的网页抓取平台。

- Scrape Owl的主要目标是抓取任何类型的数据,包括电子商务、工作委员会和房地产列表。

- 在提取材料之前,您可以运行自定义JavaScript。

- 您可以使用位置来规避本地限制并访问本地内容。

- 提供可靠的等待功能。

- 支持整页JavaScript渲染。

- 此应用程序可直接在Google表格上使用。

- 在购买任何会员资格之前,提供1000信用免费试用以体验该服务。无需使用信用卡。

11. Scrapingbee

Scrapingbee是一个网络抓取API,负责代理设置和无头浏览器。

- 它可以在页面上执行Javascript,并为每个请求轮换代理,因此您可以阅读原始HTML而不会被列入黑名单。

- 还提供了用于提取Google搜索结果的第二个API。

- 支持JavaScript渲染。

- 它具有自动代理轮换功能。

- 此应用程序可直接在Google表格上使用。

- 使用该程序需要Chrome网络浏览器。

- 它非常适合亚马逊抓取。

- 它允许您抓取Google结果。

12. Bright Data

Bright Data是世界领先的在线数据平台,提供了一种经济高效的解决方案来大规模收集公共Web数据,轻松将非结构化数据转换为结构化数据,并在完全透明和合规的同时提供卓越的客户体验。

- 它是最具适应性的,因为它带有预制解决方案,并且可扩展和可调节。

- Bright Data的下一代数据收集器在单个仪表板上提供自动化和个性化的数据流,无论集合的大小如何。

- 它每周7天、每天24小时开放,并提供客户帮助。

- 从电子商务趋势和社交网络数据到竞争对手情报和市场研究,数据集都是根据您的业务需求量身定制的。

- 您可以通过自动访问您所在行业的可靠数据来专注于您的主要业务。

- 这是最有效的,因为它使用无代码解决方案并使用更少的资源。

- 最可靠,具有最优质的数据、更长的正常运行时间、更快的数据和更好的客户服务。

13. Scraper API

您可以使用Scraper API工具来处理代理、浏览器和验证码。

- 该工具提供无与伦比的速度和可靠性,允许创建可扩展的网络抓取工具。

- 您可以通过单个API调用从任何网页获取HTML。

- 设置起来很简单,因为您所要做的就是向API端点发送带有API密钥和URL的GET请求。

- 允许更轻松地呈现JavaScript。

- 它允许您自定义每个请求的请求类型和标头。

- 具有地理位置的轮换代理。

14. Dexi Intelligent

Dexi Intelligent是一款在线抓取应用程序,可让您将任意数量的网络数据快速转化为商业价值。

- 这个在线抓取工具可以让您为您的公司节省金钱和时间。

- 它提高了生产力、准确性和质量。

- 它可以实现最快和最有效的数据提取。

- 它有一个大规模的知识捕获系统。

15. Diffbot

Diffbot使您能够从互联网上快速获取各种重要事实。

- 使用AI提取器,您将能够从任何URL中提取准确的结构化数据。

- 您无需为耗时的网站抓取或手动查询付费。

- 为了构建每个对象的完整和准确的图像,许多数据源被合并。

- 您可以使用AI Extractors从任何URL中提取结构化数据。

- 使用Crawlbot,您可以将提取规模扩大到数万个域。

- 知识图功能为Web提供了准确、完整和深入的数据,BI需要这些数据来提供有意义的见解。

16. Data Streamer

Data Streamer是一种技术,可让您从Internet上获取社交网络资料。

- 它是使用自然语言处理来检索关键元数据的最强大的在线抓取工具之一。

- Kibana和Elasticsearch用于提供集成的全文搜索。

- 基于信息检索算法、集成样板删除和内容提取。

- 建立在容错基础架构上,以提供高信息可用性。

17. Mozenda

您可以使用Mozenda从网页中提取文本、照片和PDF材料。

- 您可以使用您选择的BI工具或数据库来收集和发布在线数据。

- 它是用于组织和格式化数据文件以供发布的最佳在线抓取工具之一。

- 通过点击式界面,您可以在几分钟内创建网络抓取代理。

- 要实时收集Web数据,请使用Job Sequencer和Request Blocking功能。

- 客户管理和客户服务在业内名列前茅。

18. Data Miner Chrome 扩展

使用Data Miner浏览器插件可以更轻松地进行Web抓取和数据捕获。

- 它具有爬取多个页面以及动态数据提取的能力。

- 可以以多种方式进行数据选择。

- 它检查已抓取的信息。

- 它可以将抓取的数据保存为CSV文件。

- 本地存储用于存储抓取的数据。

- Chrome插件Web Scraper从动态站点中提取数据。

- 它可以导入和导出站点地图。

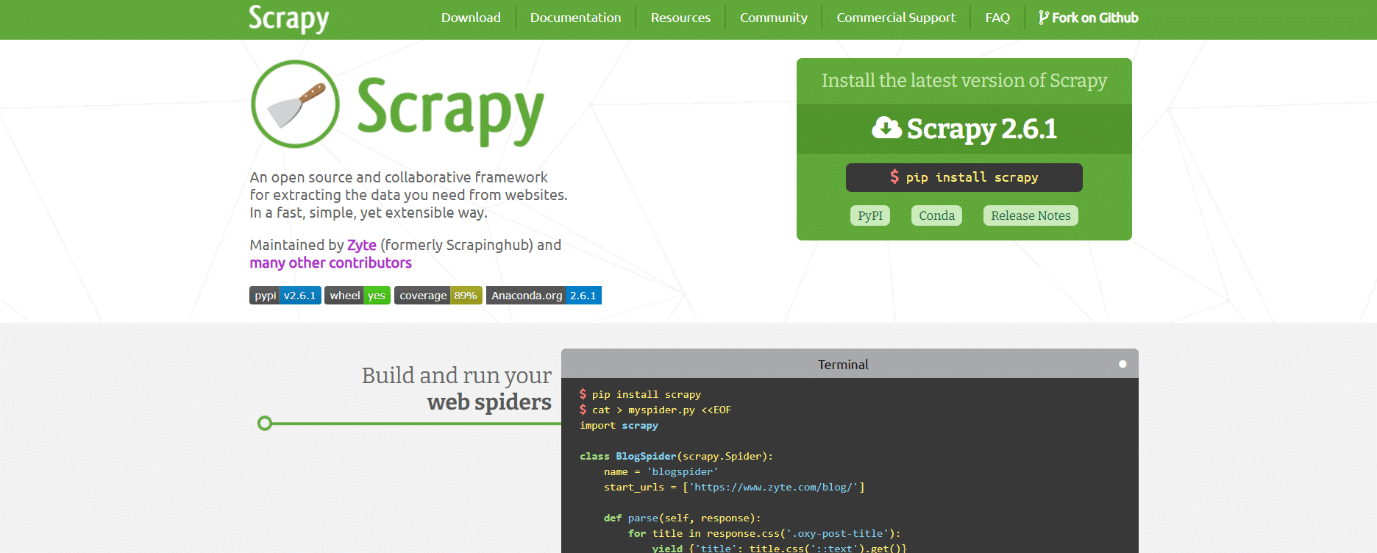

19. Scrapy

Scrapy也是最好的网页抓取工具之一。它是一个基于Python的开源在线抓取框架,用于创建网络抓取工具。

- 它为您提供了快速从网站提取数据、分析数据并以您选择的结构和格式保存数据所需的所有工具。

- 如果您有一个大型数据抓取项目并希望使其尽可能高效,同时保留很大的灵活性,则此数据抓取工具是必不可少的。

- 数据可以导出为JSON、CSV或XML。

- Linux、Mac OS X和Windows均受支持。

- 它是在Twisted异步网络技术之上开发的,这是其主要功能之一。

- Scrapy以其简单易用、丰富的文档和活跃的社区而著称。

20. ScrapeHero 云

ScrapeHero将其多年的网络爬虫知识转化为经济且易于使用的预构建爬虫程序和API,用于从亚马逊、谷歌、沃尔玛等网站抓取数据。

- ScrapeHero云爬虫包括自动旋转代理和同时运行多个爬虫的选项。

- 您无需下载或学习如何使用任何数据抓取工具或软件即可使用ScrapeHero Cloud。

- ScrapeHero云爬虫可让您立即抓取数据并将其导出为JSON、CSV或Excel格式。

- ScrapeHero Cloud的免费和轻量计划客户收到电子邮件帮助,而所有其他计划都获得优先服务。

- ScrapeHero云爬虫也可以配置为满足特定的客户要求。

- 这是一个基于浏览器的网络爬虫,适用于任何网络浏览器。

- 您不需要任何编程知识或开发爬虫;就像点击、复制和粘贴一样简单!

21. Data Scraper

Data Scraper是一款免费的在线抓取应用程序,可从单个网页抓取数据并将其保存为CSV或XSL文件。

- 它是一个浏览器扩展,可将数据转换为简洁的表格格式。

- 安装插件需要使用Google Chrome浏览器。

- 免费版每月可以抓取500页;但是,如果您想抓取更多页面,则必须升级到昂贵的计划之一。

22. Visual Web Ripper

Visual Web Ripper是用于网站的自动数据抓取工具。

- 使用此工具从网站或搜索结果中收集数据结构。

- 您可以将数据导出为CSV、XML和Excel文件,并且它具有用户友好的界面。

- 它还可以从动态网站(例如使用AJAX的网站)收集数据。

- 您只需要设置一些模板,其余的将由网络抓取工具处理。

- Visual Web Ripper提供计划选项,甚至在项目失败时向您发送电子邮件。

23. Octoparse

Octoparse是一个用户友好的网页抓取应用程序,具有可视化界面。它是最好的免费网络抓取工具之一。以下是此工具的功能。

- 它的点击式界面使您可以轻松地从网站上选择您希望抓取的信息。由于AJAX、JavaScript、cookie和其他功能,Octoparse可以处理静态和动态网页。

- 现在可以访问允许您提取大量数据的高级云服务。

- 抓取的信息可以保存为TXT、CSV、HTML或XLSX文件。

- 免费版的Octoparse允许您构建多达10个爬虫;但是,付费会员计划包括API和大量匿名IP代理等功能,这将加快您的提取速度并允许您实时下载大量数据。

24. WebHarvy

WebHarvey的可视网络抓取工具具有一个内置浏览器,用于从在线站点抓取数据。它也是最好的网络抓取工具之一。以下是此工具的一些功能。

- 它提供了一个点击式界面,使选择项目变得简单。

- 这个爬虫的好处是不需要你写任何代码。

- CSV、JSON和XML文件可用于保存数据。

- 也可以将其保存在SQL数据库中。WebHarvey具有多级类别抓取功能,可以通过跟踪每个级别的类别连接从列表页面中抓取数据。

- 正则表达式可以与互联网抓取工具一起使用,为您提供额外的自由。

- 您可以设置代理服务器以在从网站提取数据时隐藏您的IP,从而保护一定程度的隐私。

25. PySpider

PySpider也是最优秀的免费网络抓取工具之一,它是一个基于Python的网络爬虫。下面列出了该工具的一些功能。

- 它具有分布式架构并支持Javascript页面。

- 你可能有很多这样的爬虫。PySpider可以将数据存储在您选择的任何后端,包括MongoDB、MySQL、Redis等。

- 可以使用RabbitMQ、Beanstalk和Redis等消息队列。

- PySpider的优势之一是其简单的用户界面,它允许您更改脚本、监控正在运行的活动并检查结果。

- 信息可以JSON和CSV格式下载。

- 如果您正在使用基于网站的用户界面,PySpider是需要考虑的Internet抓取工具。

- 它也适用于使用大量AJAX的网站。

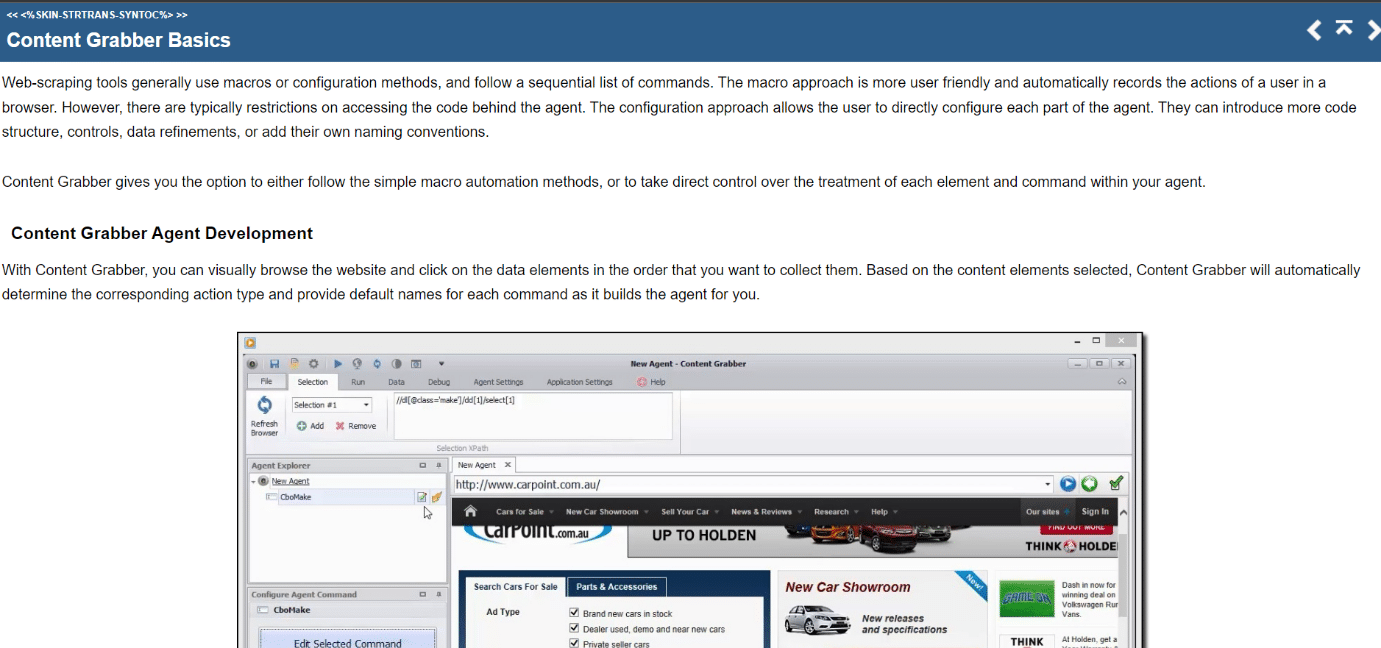

26. Content Grabber

Content Grabber是一个可视化的在线抓取工具,具有易于使用的点击式界面来选择项目。以下是此工具的功能。

- CSV、XLSX、JSON和PDF是可以导出数据的格式。使用此工具需要中级编程技能。

- 分页、无限滚动页面和弹出窗口都可以通过其用户界面实现。

- 它还具有AJAX/Javascript处理、验证码解决方案、正则表达式支持和IP轮换(使用Nohodo)。

27. Kimurai

Kimurai是一个Ruby网页抓取框架,用于创建抓取工具和提取数据。它也是最优秀的免费网络抓取工具之一。以下是此工具的一些功能。

- 它允许我们使用Headless Chromium/Firefox、PhantomJS或基本的HTTP查询开箱即用地抓取JavaScript生成的网页并与之交互。

- 它具有与Scrapy类似的语法和可配置选项,包括设置延迟、轮换用户代理和默认标头。

- 它还使用Capybara测试框架与网页交互。

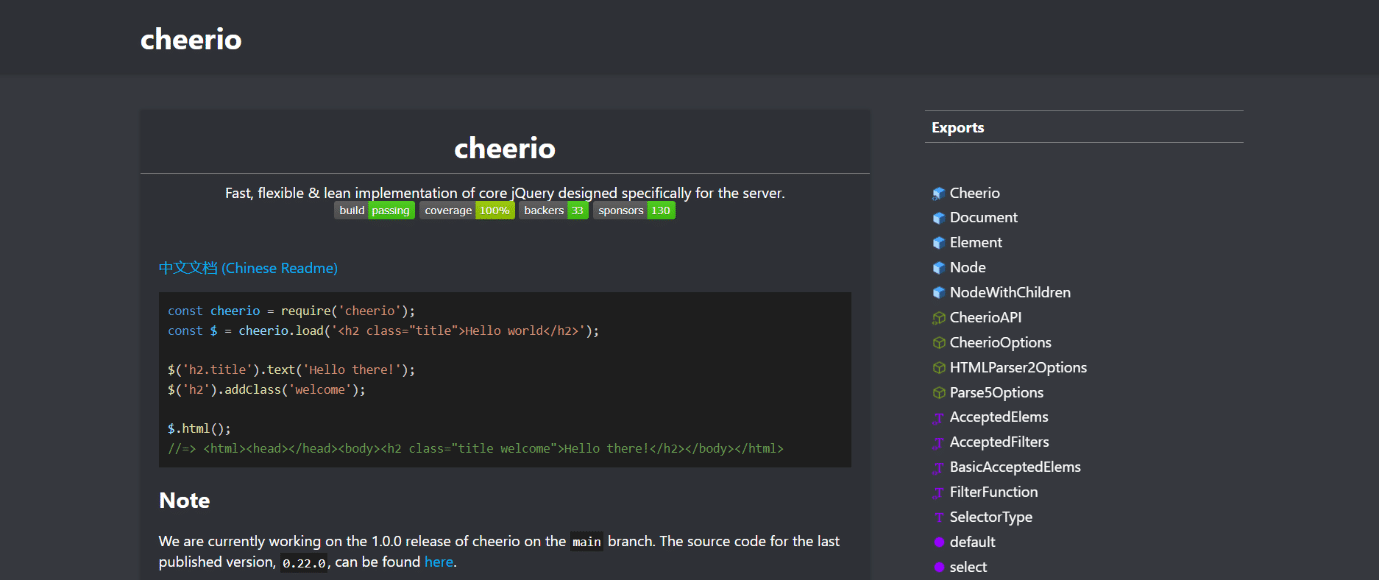

28. Cheerio

Cheerio是另一种最好的网络抓取工具。它是一个解析HTML和XML文档并允许您使用jQuery语法对下载的数据进行操作的包。以下是此工具的功能。

- 如果您正在开发JavaScript网络爬虫,Cheerio API提供了一种用于解析、修改和显示数据的快速选择。

- 它不会在Web浏览器中呈现输出、应用CSS、加载外部资源或运行JavaScript。

- 如果需要这些功能中的任何一个,您应该查看PhantomJS或JSDom。

29. Puppeteer

Puppeteer是一个Node包,它允许您使用强大而简单的API管理Google的无头Chrome浏览器。下面列出了该工具的一些功能。

- 它在后台运行,通过API执行命令。

- 无头浏览器是一种能够发送和接收请求但缺少图形用户界面的浏览器。

- 如果您要查找的信息是利用API数据和Javascript代码的组合生成的,那么Puppeteer是该任务的正确解决方案。

- 您可以通过在用户所做的相同位置键入和单击来模仿用户的体验。

- Puppeteer也可用于捕获打开Web浏览器时默认显示的网页屏幕截图。

30. Playwright

Playwright是一个为浏览器自动化而设计的Microsoft Node库。它是另一种最好的免费网络抓取工具。以下是此工具的一些功能。

- 它提供称职、可靠和快速的跨浏览器网络自动化。

- Playwright旨在通过消除不稳定、提高执行速度和深入了解浏览器的工作原理来改进自动化UI测试。

- 它是一个现代浏览器自动化应用程序,在许多方面都可以与Puppeteer相媲美,并且预装了兼容的浏览器。

- 它的主要优势是跨浏览器兼容性,因为它可以运行Chromium、WebKit和Firefox。

- Playwright定期与Docker、Azure、Travis CI和AppVeyor集成。

31. PJScrape

PJscrape是一个基于Python的在线抓取工具包,它使用Javascript和JQuery。以下是此工具的功能。

- 它旨在与PhantomJS一起使用,因此您可以在完全呈现、启用Javascript的上下文中从命令行抓取站点,而无需浏览器。

- 这意味着您不仅可以访问DOM,还可以访问Javascript变量和函数,以及AJAX加载的内容。

- 刮板功能在整个浏览器的上下文中进行评估。

***

我们希望本指南对选择最佳网络抓取工具有所帮助。请告诉我们您觉得哪种工具对您来说最容易使用。请访问我们的页面以获取更多实用的提示和技巧,并在下方留下您的评论。