若您对人工智能抱有浓厚兴趣,那么本文定能助您深入理解其复杂性。我将在此引导您探索 LLMOps 平台的世界,并为您清晰阐述用于测试、优化及部署大型语言模型(LLM)的关键工具。

文中列出的这些卓越平台在释放语言模型的全部潜能方面起着至关重要的作用,它们为模型的开发与管理提供了创新性的解决方案。

包括谷歌、OpenAI 和微软在内的知名机构,都在利用 LLMOps 平台,以确保对其语言模型进行全面的测试、持续的改进以及有效的部署,从而获得可靠且精准的结果。

考虑到 LLMOps 对于许多人来说可能是一个新概念,我们首先对 LLMOps 进行基础性了解:包括其重要性、功能及优势。

有了这个基础,我们就可以继续实现我们的主要目标——根据读者的具体需求,为他们识别出最适用的工具。本文中的主要列表文章将作为实现这一目标的指南。

什么是 LLMOps?

LLMOps 代表语言模型操作。它涵盖了对大型语言模型(例如人工智能领域使用的模型)的管理、部署和改进。 LLMOps 涉及训练、测试和维护这些模型的工具与流程,确保它们运行良好,并随着时间的推移保持准确性。

尽管原型制作大型语言模型相对容易,但在商业产品中应用它们却面临诸多挑战。大型语言模型的开发周期包括数据准备、模型微调和部署等复杂的步骤,需要团队的无缝协作。LLMOps 覆盖了整个周期,确保实验、部署和增强过程顺利进行。

最后,我希望您理解 LLMOps 平台的含义,因为它将为您提供清晰的认知,并且沿着这条道路前进必将为您带来阅读后的收获。

LLMOps 平台促进了数据科学家与工程师之间的协作,帮助进行迭代的数据探索。它支持实时协作、实验跟踪、模型管理以及受控的 LLM 部署。 LLMOps 可以自动执行整个机器学习生命周期的操作、同步和监控。

LLMOps 如何工作?

LLMOps 平台简化了语言模型的整个生命周期。它们集中进行数据准备,支持实验,并允许针对特定任务进行微调。 这些平台还有助于顺利部署、持续监控和无缝的版本转换。

通过自动化促进协作、最大限度地减少错误,并支持持续改进。 本质上,LLMOps 优化了不同应用中语言模型的管理。

LLMOps 的好处

我发现 LLMOps 的主要优势包括效率、准确性和可扩展性。 以下是 LLMOps 所提供优势的详细说明:

- 效率:LLMOps 平台优化了语言模型的开发、测试和部署的整个过程,从而节省时间和精力。

- 协作:这些平台促进了数据科学家、工程师和利益相关者之间的无缝协作,从而促进有效的团队合作。

- 准确性:LLMOps 通过持续监控和改进模型来保持并提高模型的准确性。

- 自动化:LLMOps 可自动执行多项任务,包括数据预处理和监控,从而减少手动干预的需求。

- 可扩展性:通过有效扩展模型,LLMOps 平台可以轻松适应不断增长的工作负载或需求。

- 轻松部署:LLMOps 确保模型顺利集成到应用程序或系统中,最大限度地减少与部署相关的挑战。

总而言之,LLMOps 提高了效率、准确性和可扩展性,同时促进了协作、自动化和无缝部署。

现在,我们继续探讨平台列表。 此列表是 techblik.com 的指南,但最终选择最适合您需求的列表,取决于您的具体要求。

迪菲

您是否对 GPT-4 等 LLM 技术的快速发展感到兴奋,并对其潜在的实际应用前景充满好奇? 迪菲 旨在满足您的需求。 它使得开发人员,甚至是那些没有深厚技术背景的人,能够利用各种语言模型快速创建有价值的应用程序。 这些应用程序不仅用户友好,而且易于使用。 它们还将不断得到改进。

主要特征:

- 用户友好的 LLMOps 平台:使用 GPT-4 轻松开发人工智能应用程序并进行可视化管理。

- 上下文 AI 与您的数据:利用文档、网页内容或概念注释作为人工智能的上下文。 Dify 可以处理预处理等任务,从而节省您的开发时间。

- 释放 LLM 的潜力:Dify 确保无缝的模型访问、上下文嵌入、成本控制和数据注释,以实现流畅的人工智能创建过程。

- 现成的模板:从对话和文本生成模板中进行选择,这些模板可针对您的特定应用程序进行定制。

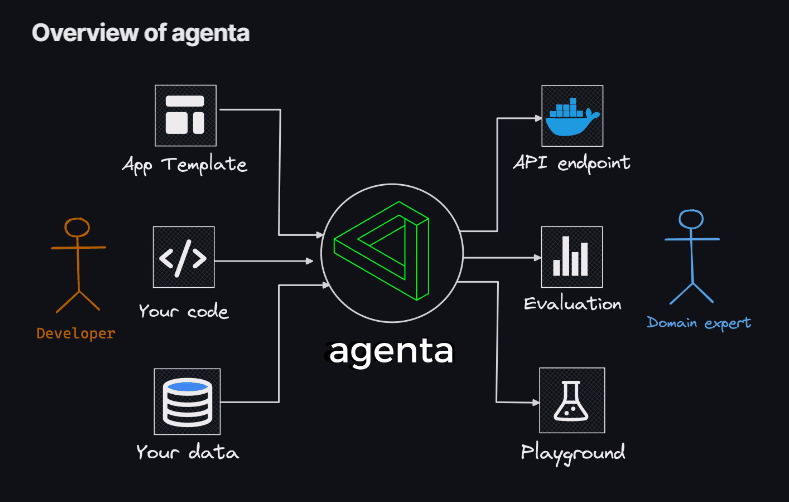

阿杰塔

如果您正在寻找一种灵活使用编码方式来构建 LLM 应用程序,而不受模型、库或框架的限制,那么 阿杰塔 是您的理想选择。 Agenta 作为一个开源的端到端平台,旨在简化将复杂的大型语言模型应用程序(LLM 应用程序)投入生产的过程。

使用 Agenta,您可以快速尝试和版本化提示、参数以及复杂的策略。 这包括通过嵌入、代理和自定义业务逻辑进行上下文学习。

主要特征:

- 参数探索:直接在代码中指定应用程序的参数,并通过直观的 Web 平台轻松地进行实验。

- 性能评估:使用精确匹配、AI Critic、人工评估等各种方法来评估应用程序在测试集上的功效。

- 测试框架:使用用户界面轻松创建测试集,无论是上传 CSV 文件,还是通过我们的 API 无缝连接到您的数据。

- 协作环境:通过与协作者共享您的应用程序,并邀请他们提供反馈和见解,以促进团队合作。

- 轻松部署:只需单击一下即可将应用程序作为 API 启动,从而简化部署过程。

此外,Agenta 还促进与领域专家的合作,以实现快速的工程和评估。 另一个亮点是 Agenta 能够系统地评估您的 LLM 应用程序,并促进应用程序的一键部署。

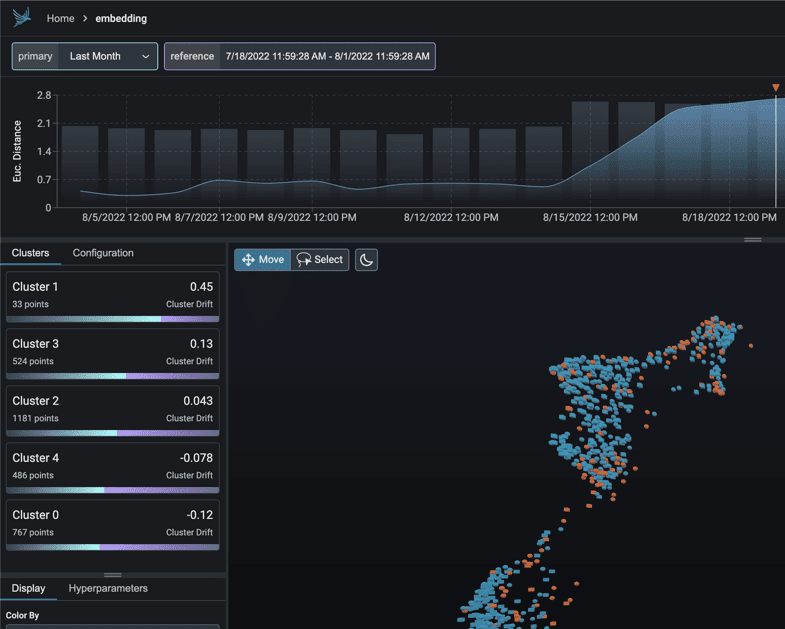

凤凰

立即开始 MLOps 洞察之旅,借助 凤凰。这款巧妙的工具能够无缝地解锁模型性能、漂移和数据质量的可观察性,而无需进行复杂的配置。

作为一个以笔记本为中心的前沿 Python 库,Phoenix 利用嵌入的力量来挖掘 LLM、CV、NLP 和表格模型中隐藏的复杂性。借助 Phoenix 带来的强大功能,提升您的模型性能。

主要特征:

- 嵌入式漂移调查:深入研究大量的 UMAP 点云,分析欧几里得距离和精确漂移簇。

- 通过聚类进行漂移和性能分析:通过 HDBSCAN 将数据分解为具有显著漂移或性能不佳的聚类。

- UMAP 支持的探索性数据分析:根据模型的属性、漂移和性能对 UMAP 点云进行着色,揭示有问题的部分。

朗基特

朗基特 是一个用于文本度量的开源工具包,旨在有效地监控大型语言模型。

LangKit 的创建源于这样的认识:将包括大型语言模型在内的语言模型投入生产会带来各种风险。 无数潜在的输入组合会导致同样多的输出,这是一个相当大的挑战。

主要特征:

- 即时注入分析:使用已知的快速注入攻击来衡量相似性得分。

- 情感分析:评估文本中的情感基调。

- 文本质量评估:评估可读性、复杂性和成绩分数。

- 越狱检测:识别与已知越狱尝试的相似性得分。

- 毒性分析:检测所提供内容的毒性级别。

文本的非结构化性质使得机器学习可观察性领域的问题进一步复杂化——这是一个值得解决的挑战。毕竟,缺乏对模型行为的洞察可能会产生重大影响。

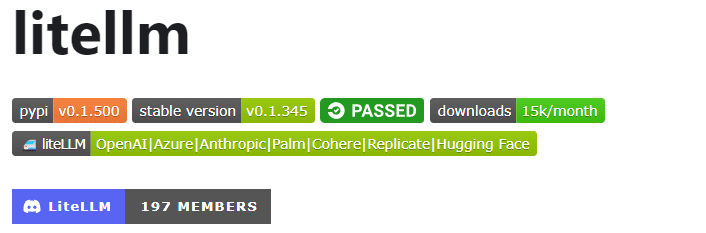

莱特法学硕士

借助 莱特法学硕士,可以使用 OpenAI 格式的轻量级软件包,简化与各种 LLM API(Anthropic、Huggingface、Cohere、Azure OpenAI 等)的交互。

该软件包简化了从 OpenAI、Azure、Cohere 和 Anthropic 等提供商调用 API 端点的过程。它将输入转换为相关提供商的完成和嵌入端点,确保统一的输出。您可以随时访问文本回复 `[‘choices’][0][‘message’][‘content’]`。

主要特征:

- 简化的 LLM API 调用:简化与 Anthropic、Cohere、Azure OpenAI 等 LLM API 的交互。

- 轻量级软件包:用于调用 OpenAI、Azure、Cohere、Anthropic 和 API 端点的紧凑解决方案。

- 输入翻译:管理输入到相应提供商的完成和嵌入端点的翻译。

- 异常映射:将跨提供商的常见异常映射到 OpenAI 异常类型,以实现标准化错误处理。

此外,该软件包还包括异常映射功能。它将不同提供商的标准异常与 OpenAI 异常类型保持一致,确保处理错误的一致性。

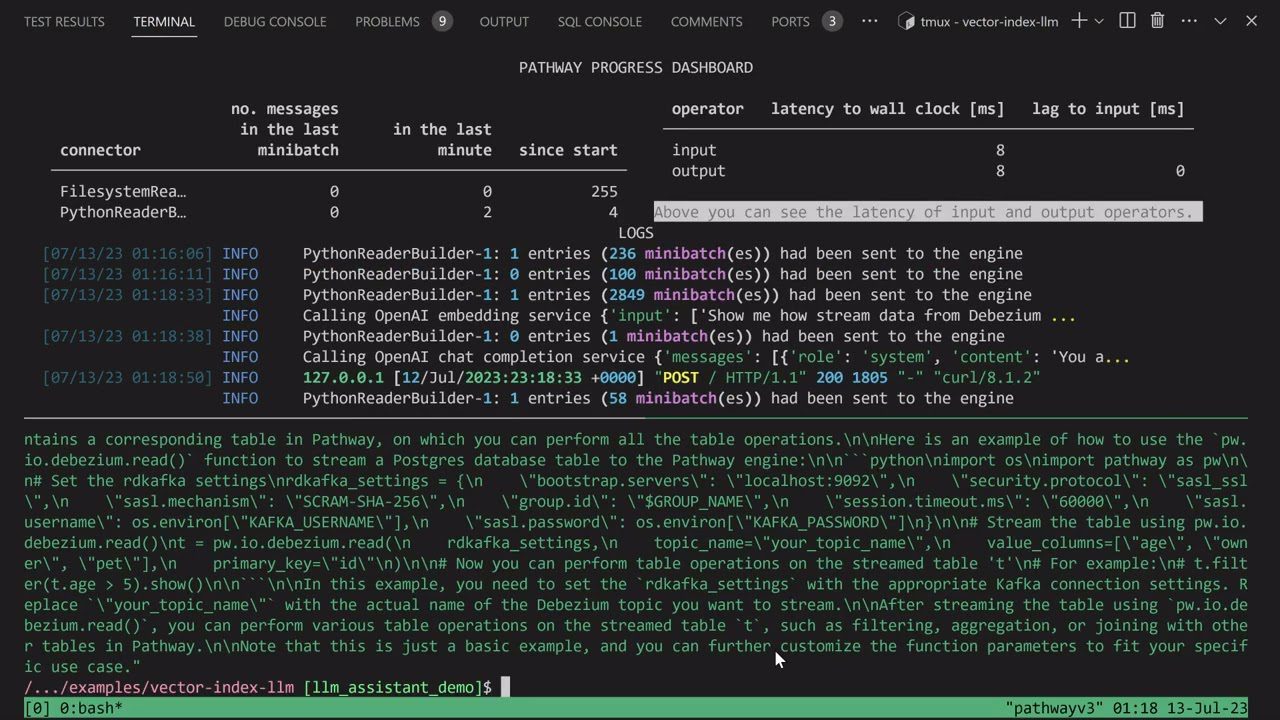

法学硕士申请

踏上打造独特 Discord 人工智能聊天机器人的旅程,增强其回答问题的能力,或者探索类似的人工智能机器人创意。所有这些令人兴奋的功能都通过 法学硕士申请来实现。

我将介绍 Pathways LLM-App——一个精心设计的 Python 库,旨在加速突破性人工智能应用程序的开发。

主要特征:

- 专为本地机器学习模型设计:LLM 应用程序配置为与本地机器学习模型一起运行,并保持在组织的边界内。

- 实时数据处理:该库能够熟练地管理实时数据源,包括新闻源、API 和 Kafka 数据流,同时具有用户权限和强大的安全性。

- 流畅的用户会话:该库的查询构建过程可以有效地处理用户会话,确保无缝交互。

这种特殊的资产使您能够在解决用户查询时提供反映人类交互的即时响应。它通过有效地利用数据源中隐藏的最新见解来完成这一壮举。

法学硕士流程

法学硕士流程 是一个专门为简化、澄清和增强开发大型语言模型 (LLM) 应用程序(如聊天机器人、问答系统和代理)而设计的框架。

由于提示和 LLM 调用之间错综复杂的关系,在实际场景中,复杂性可能会被放大。

LLMFlows 的创建者设想了一个显式的 API,使用户能够编写清晰且易于理解的代码。 该 API 简化了复杂的 LLM 交互的创建,确保各种模型之间的无缝流动。

主要特征:

- 无缝配置 LLM 课程,精心选择特定模型、参数和设置。

- 确保稳健的 LLM 交互,并在模型调用失败时自动重试,从而确保可靠性。

- 当输入可用时,利用异步流并行执行 LLM,从而优化性能和效率。

- 将个性化字符串操作功能直接注入流程中,促进 LLM 调用之外的定制文本转换。

- 通过回调保持对 LLM 支持的应用程序的完全控制和监督,从而全面监控和了解执行流程。

LLMFlows 的课程为用户提供了不受限制的权限,无需隐藏提示或 LLM 调用。

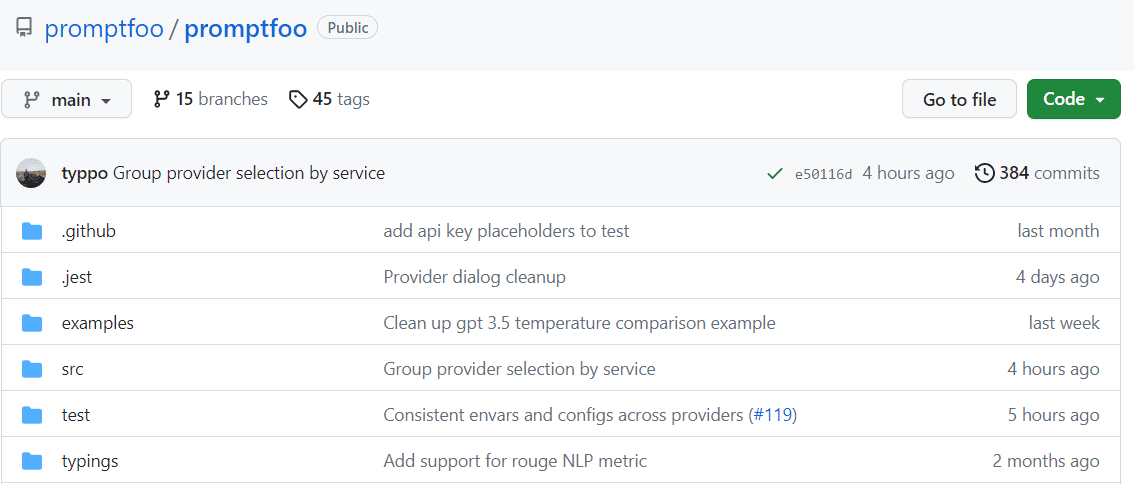

提示富

通过缓存和并发测试加速评估,借助 提示符。 它提供了命令行界面(CLI)和库,支持对 LLM 输出质量的评估。

主要特征:

- 久经考验的可靠性:Promptfoo 经过精心设计,旨在评估和增强 LLM 应用程序,以满足生产环境中超过 1000 万用户的需求。 提供的工具非常灵活,可适应各种设置。

- 用户友好的测试用例:定义评估,无需编写代码或处理复杂的笔记本。 简单的声明性方法简化了流程。

- 语言灵活性:无论您使用 Python、Javascript 还是任何其他语言,Promptfoo 都能满足您的偏好。

此外,Promptfoo 可以根据预定义的测试用例对提示进行系统测试。 这有助于通过促进 LLM 输出的直接并排比较来评估质量和识别回归。

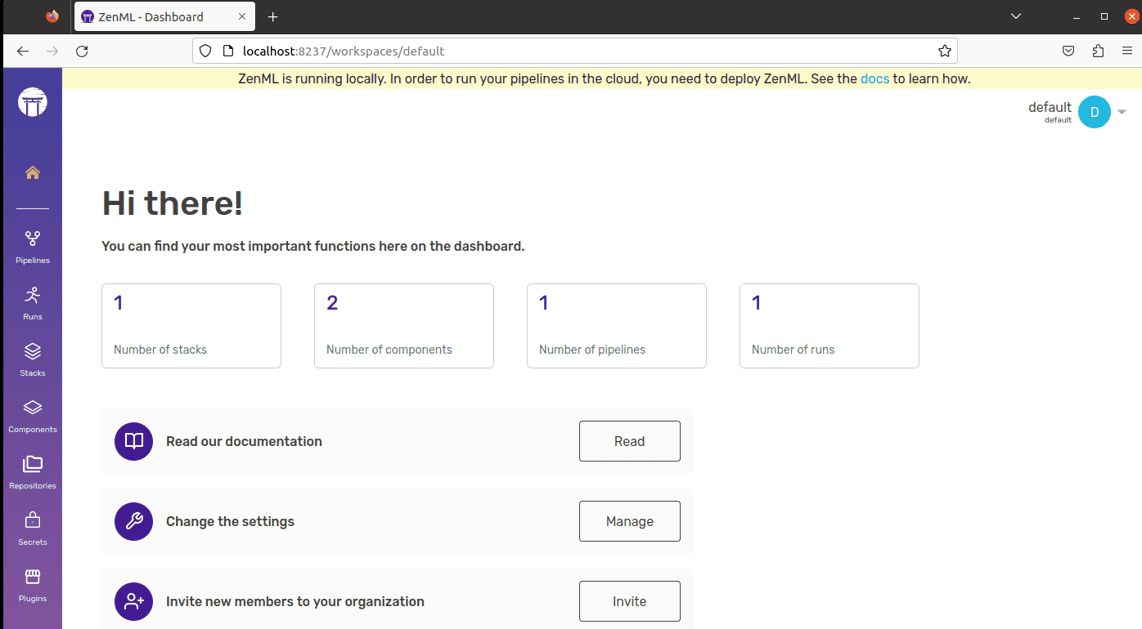

ZenML

欢迎了解 ZenML – 一种适应性强的开源工具,旨在让专业人士和组织更容易地使用机器学习管道。 想象一下,有一个工具可以让您创建可用于实际应用的机器学习管道,无论您的项目多么复杂。

ZenML 将技术内容与代码分离,使得开发人员、数据科学家、MLOps 专家和 ML 工程师能够更直接地合作。 这意味着您的项目可以更顺利地从想法阶段过渡到准备实施的阶段。

主要特征:

- 对于数据科学家:当 ZenML 准备好代码以供实际使用时,专注于创建和测试模型。

- 对于 MLOps 基础设施专家:快速设置、管理和部署复杂的系统,以便您的同事可以轻松使用它们。

- 对于 ML 工程师:在 ZenML 的帮助下处理机器学习项目从开始到结束的每一步。 这意味着更少的人工交接和更清晰的组织流程。

ZenML 适合所有人——无论您是专业人士还是组织成员。 它提供了一种为机器学习任务编写代码的方法,并且它可以与您使用的任何云服务或工具良好配合。 此外,它还可以帮助您在一个地方管理项目,因此您不必担心处理不同的事务。只需编写一次代码即可在其他系统上轻松使用。

最后的想法

在这个激动人心的探索之旅中,请始终记住,每个平台都提供了一把能够解锁您人工智能愿望的独特钥匙。 您的选择将决定您的道路,因此请明智地选择!

您还可以探索一些人工智能工具,以便开发人员可以更快地构建应用程序。