Meta 公司在 2023 年夏季推出了 Llama 2。这个新版本的 Llama 模型经过了精细的调整,其令牌数量比最初的 Llama 模型增加了 40%,上下文长度也翻了一倍。它在性能上明显优于其他可用的开源模型。通过在线平台和 API 访问 Llama 2 是最快速、最便捷的方式。然而,为了获得最佳的用户体验,最好还是直接在您的计算机上安装并加载 Llama 2。

考虑到这一点,我们特别创建了一份详细的分步指南,教您如何使用 Text-Generation-WebUI 在本地计算机上加载经过量化的 Llama 2 LLM 模型。

为什么选择在本地安装 Llama 2?

人们选择直接运行 Llama 2 的原因有很多。其中一些原因包括对隐私的考虑、对个性化定制的需求,以及对离线功能的要求。如果您正在为您的项目研究、微调或集成 Llama 2,那么通过 API 访问 Llama 2 可能不是最理想的方案。在个人电脑上本地运行大型语言模型(LLM)的主要目的是减少对第三方人工智能工具的依赖,从而能够随时随地使用人工智能,而无需担心将潜在的敏感数据泄露给公司或其他组织。

话不多说,让我们开始学习如何在本地安装 Llama 2 的详细步骤。

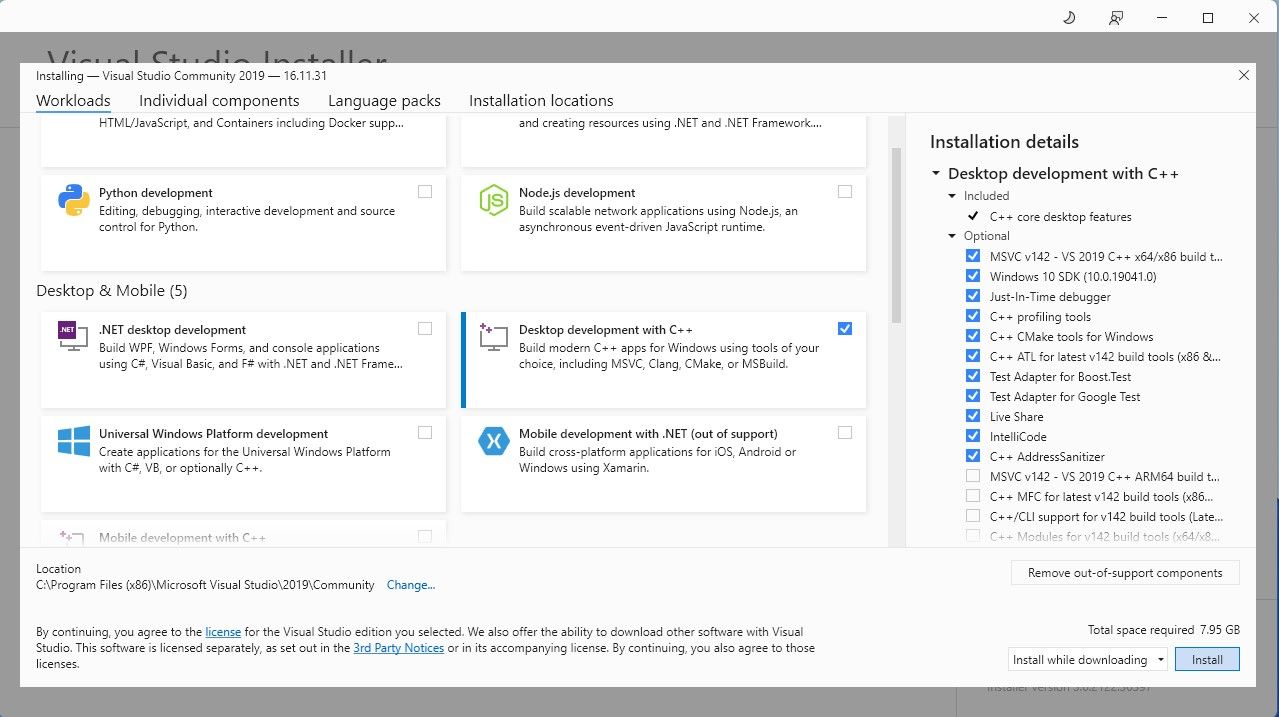

为了简化操作过程,我们将采用 Text-Generation-WebUI(一个通过图形用户界面加载 Llama 2 的程序)的一键安装程序。但是,要让这个安装程序顺利运行,您需要先下载 Visual Studio 2019 的构建工具并安装必要的组件。

下载: Visual Studio 2019 (免费)

- 请下载该软件的社区版本。

- 接下来,安装 Visual Studio 2019 并启动该软件。启动后,勾选“使用 C++ 进行桌面开发”的选项框,然后点击安装。

现在您已经安装了使用 C++ 进行桌面开发的组件,是时候下载 Text-Generation-WebUI 的一键安装程序了。

第二步:安装 Text-Generation-WebUI

Text-Generation-WebUI 一键安装程序是一个脚本,它可以自动创建所需的文件夹,并设置 Conda 环境,以及所有运行 AI 模型所需的必要组件。

要安装这个脚本,请点击“代码”>“下载 ZIP”来下载一键安装包。

下载: Text-Generation-WebUI 安装程序 (免费)

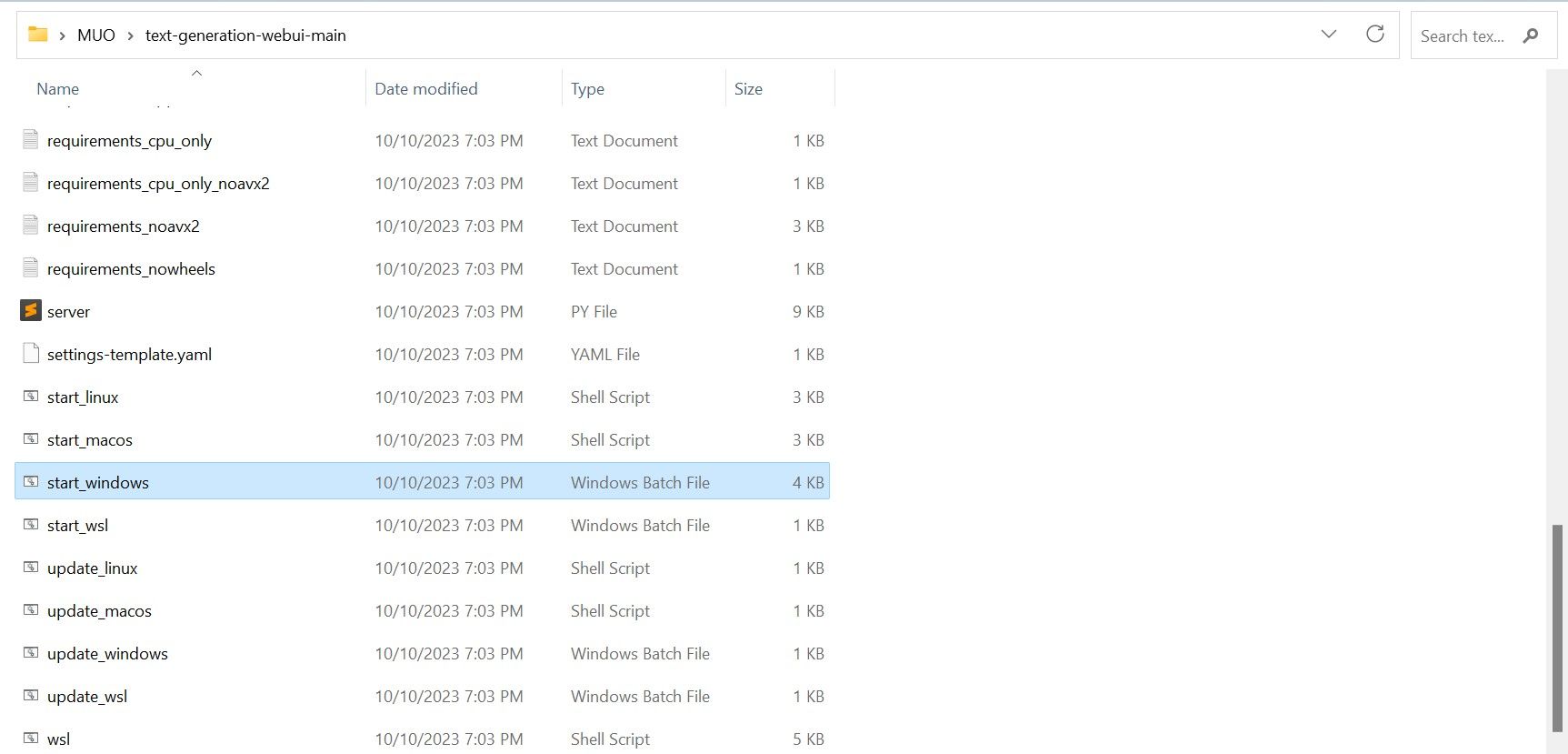

- 下载完成后,将 ZIP 文件解压到您喜欢的位置,然后打开解压后的文件夹。

- 在这个文件夹中,向下滚动找到适合您操作系统的启动程序。双击相应的脚本来运行程序。

- 如果您使用的是 Windows 系统,请选择 start_windows 批处理文件。

- 对于 MacOS 系统,请选择 start_macos shell 脚本。

- 对于 Linux 系统,请选择 start_linux shell 脚本。

- 您的防病毒软件可能会发出警告;这是正常现象。这个提示仅仅是关于运行批处理文件或脚本的防病毒误报。请点击“运行”继续。

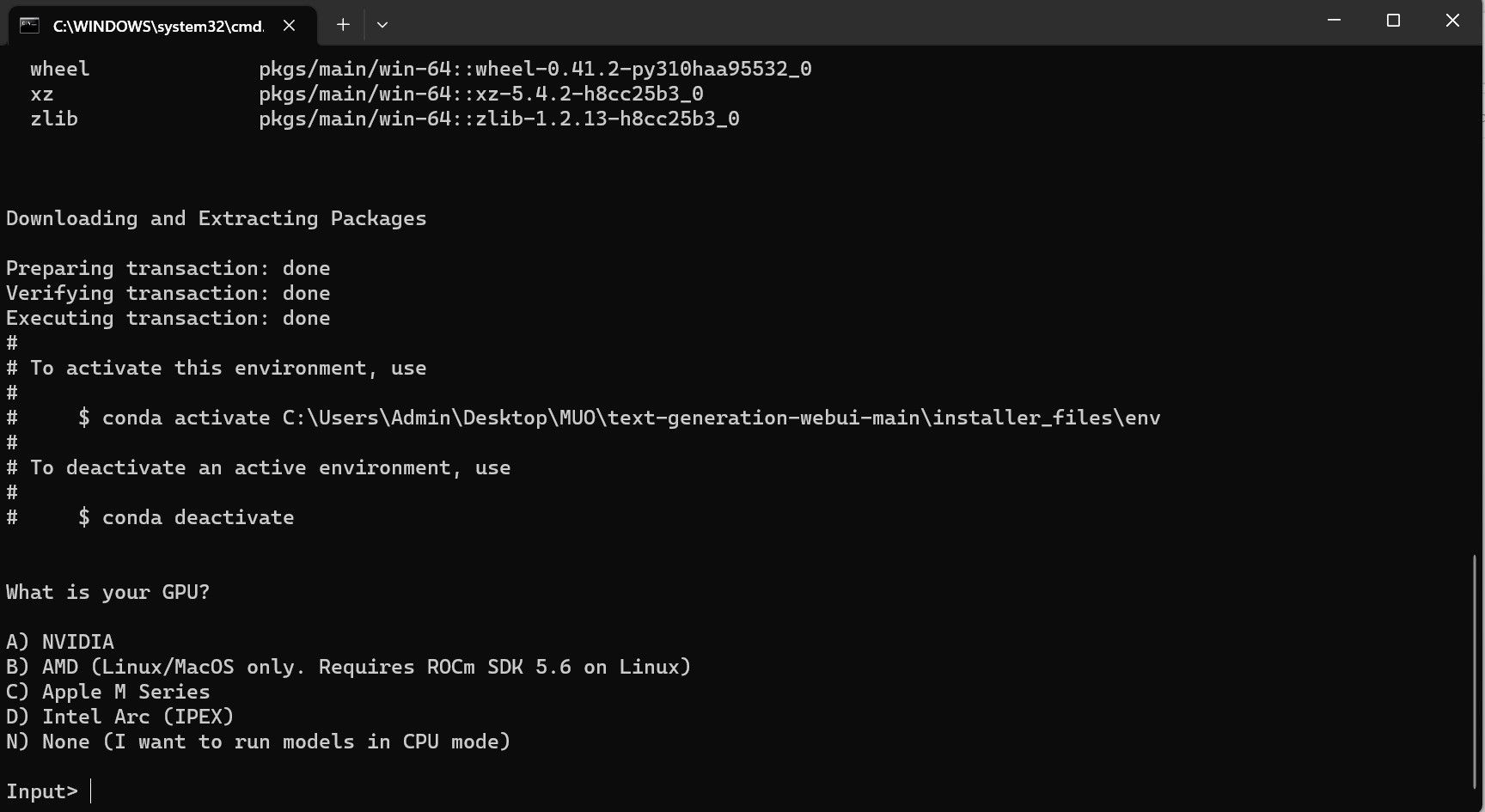

- 终端将会打开并开始设置。在安装过程中,系统会暂停并询问您正在使用哪种 GPU。请选择您计算机上安装的相应类型的 GPU,然后按回车键。如果您的电脑没有独立显卡,请选择“无”(我希望在 CPU 模式下运行模型)。请注意,与使用专用 GPU 运行模型相比,在 CPU 模式下运行的速度会慢很多。

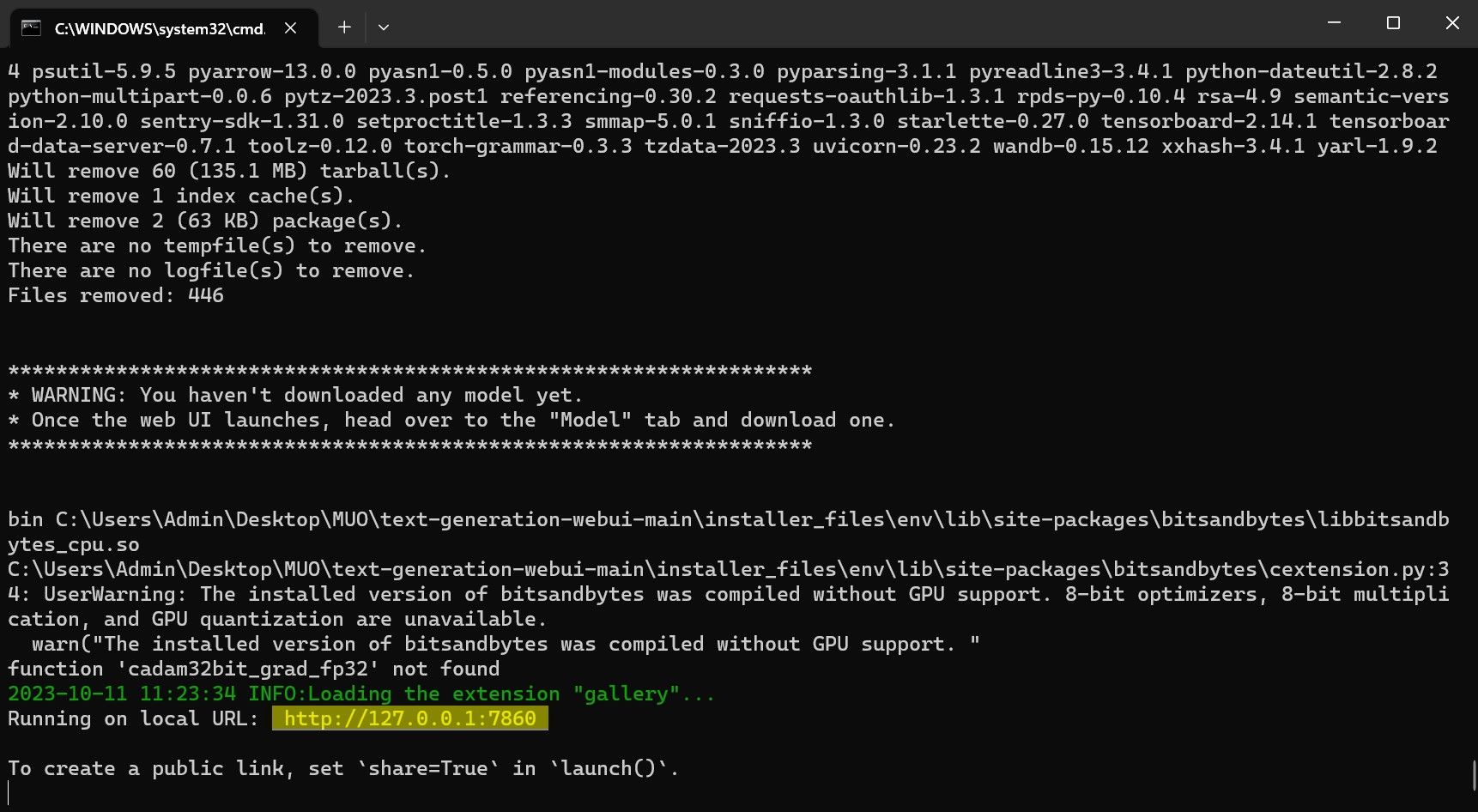

- 设置完成后,您现在可以在本地启动 Text-Generation-WebUI。您可以通过打开您喜欢的网络浏览器并在地址栏中输入程序提供的 IP 地址来完成此操作。

- WebUI 现在可以使用了。

然而,这个程序只是一个模型加载器。接下来,让我们下载 Llama 2 模型,以便启动模型加载器。

第三步:下载 Llama 2 模型

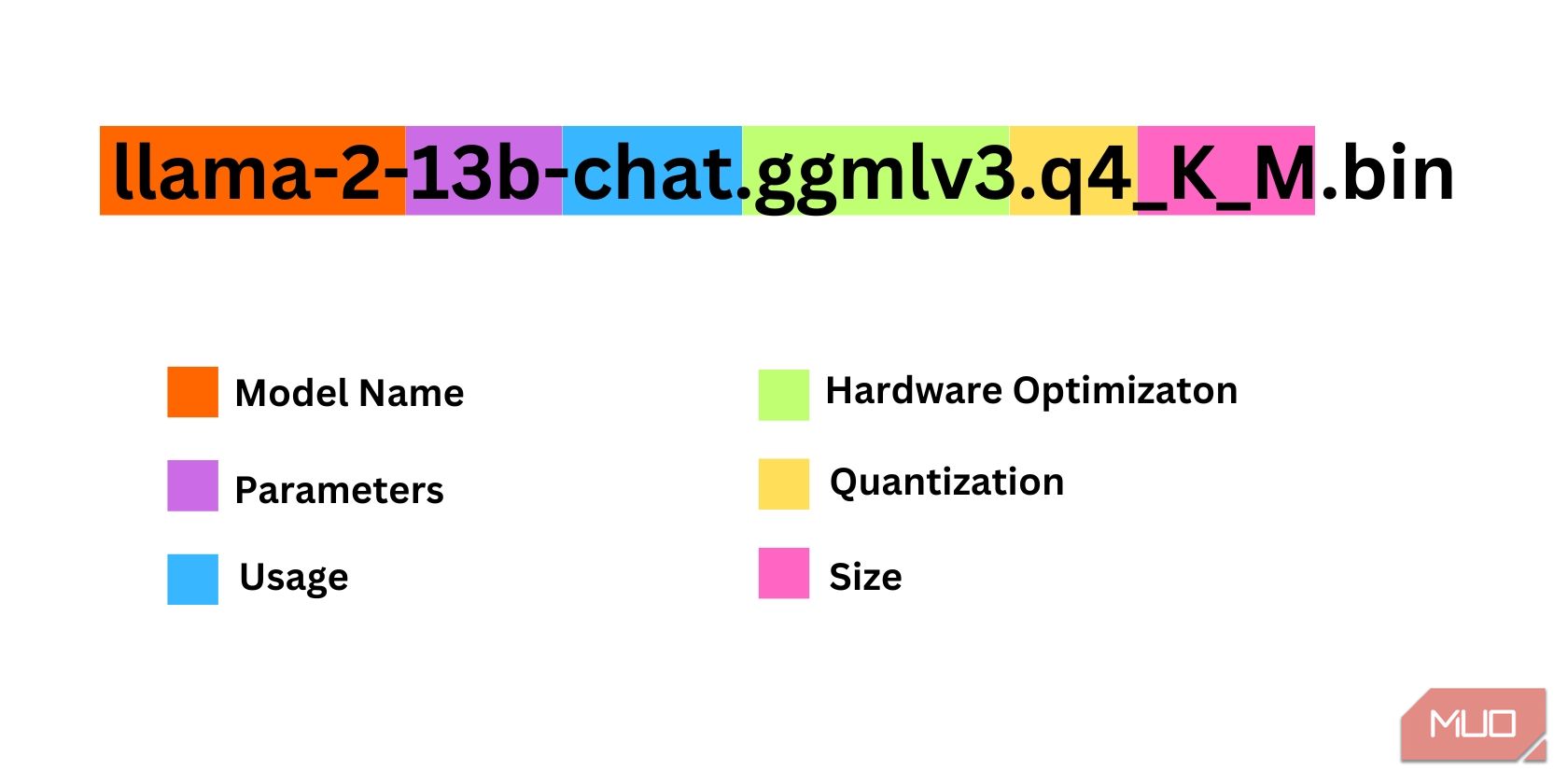

在决定您需要哪个版本的 Llama 2 时,有很多因素需要考虑,包括模型的参数、量化、硬件优化、大小和用途。所有这些信息都可以在模型名称中找到。

- 参数:指用于训练模型的参数数量。更大的参数可以产生更强大的模型,但会降低运行性能。

- 用途:模型可以是标准的,也可以是专门用于聊天的。聊天模型经过优化,可以像 ChatGPT 这样的聊天机器人一样使用,而标准模型则是默认版本。

- 硬件优化:指的是哪种硬件最适合运行该模型。GPTQ 表示模型针对在专用 GPU 上运行进行了优化,而 GGML 则表示针对在 CPU 上运行进行了优化。

- 量化:表示模型中权重和激活的精度。对于推理来说,q4 的精度通常是最佳选择。

- 尺寸:指具体模型的尺寸大小。

请注意,某些模型的排列方式可能会有所不同,甚至可能不显示相同类型的信息。然而,这种命名约定在 HuggingFace 模型库中相当常见,因此了解这些信息仍然非常有价值。

在这个例子中,该模型被标识为一个中型的 Llama 2 模型,使用 130 亿个参数进行了训练,并且使用专用 CPU 针对聊天推理进行了优化。

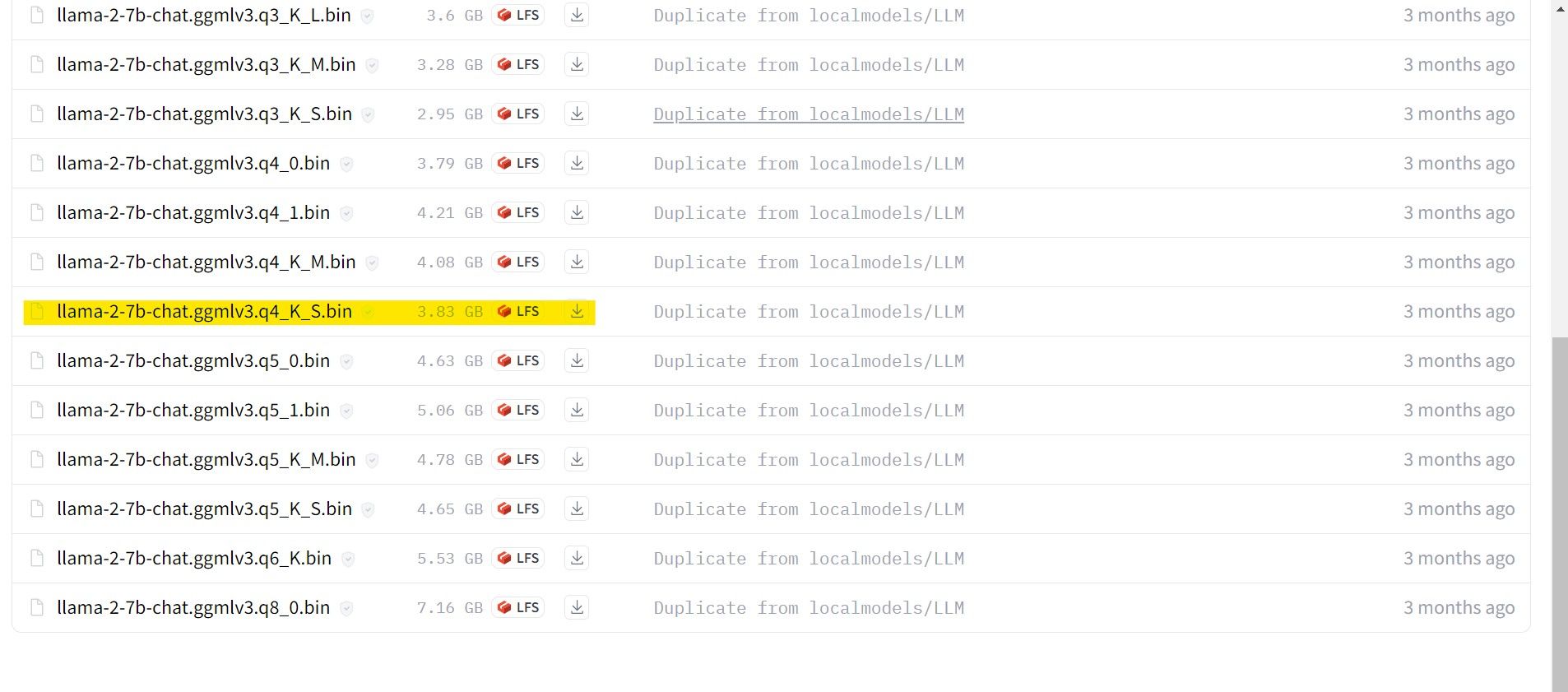

对于在专用 GPU 上运行的模型,请选择 GPTQ 模型;对于使用 CPU 的模型,请选择 GGML 模型。如果您希望像使用 ChatGPT 一样与模型进行聊天,请选择聊天模型,但如果您想探索模型的全部功能,请使用标准模型。关于参数,需要注意的是,更大的模型会带来更好的结果,但也会降低运行性能。我个人建议您从 7B 型号开始。至于量化,请使用 q4,因为它专为推理而设计。

下载: GGML (免费)

下载: GPTQ (免费)

现在您已经知道您需要哪个版本的 Llama 2 模型,请继续下载您所需的模型。

就我个人而言,由于我是在笔记本电脑上运行此程序,因此我将使用针对聊天进行了微调的 GGML 模型 llama-2-7b-chat-ggmlv3.q4_K_S.bin。

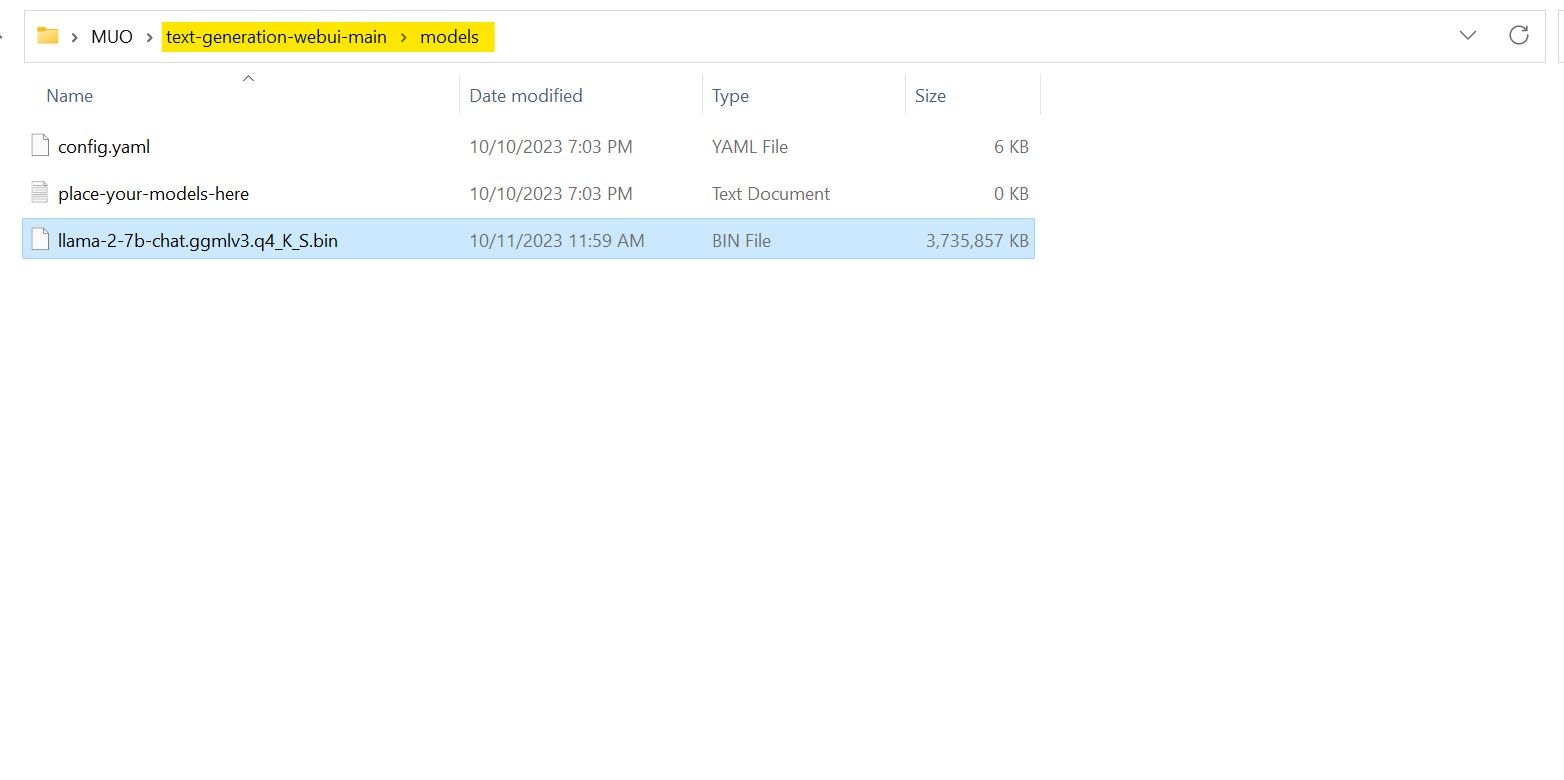

下载完成后,将模型文件放入 text-generation-webui-main > models 文件夹中。

现在,您已经下载了模型并将其放置在模型文件夹中,是时候配置模型加载器了。

第四步:配置 Text-Generation-WebUI

现在,让我们进入配置阶段。

- 再次,运行 start_(您的操作系统)文件来启动 Text-Generation-WebUI(请参考上面的步骤)。

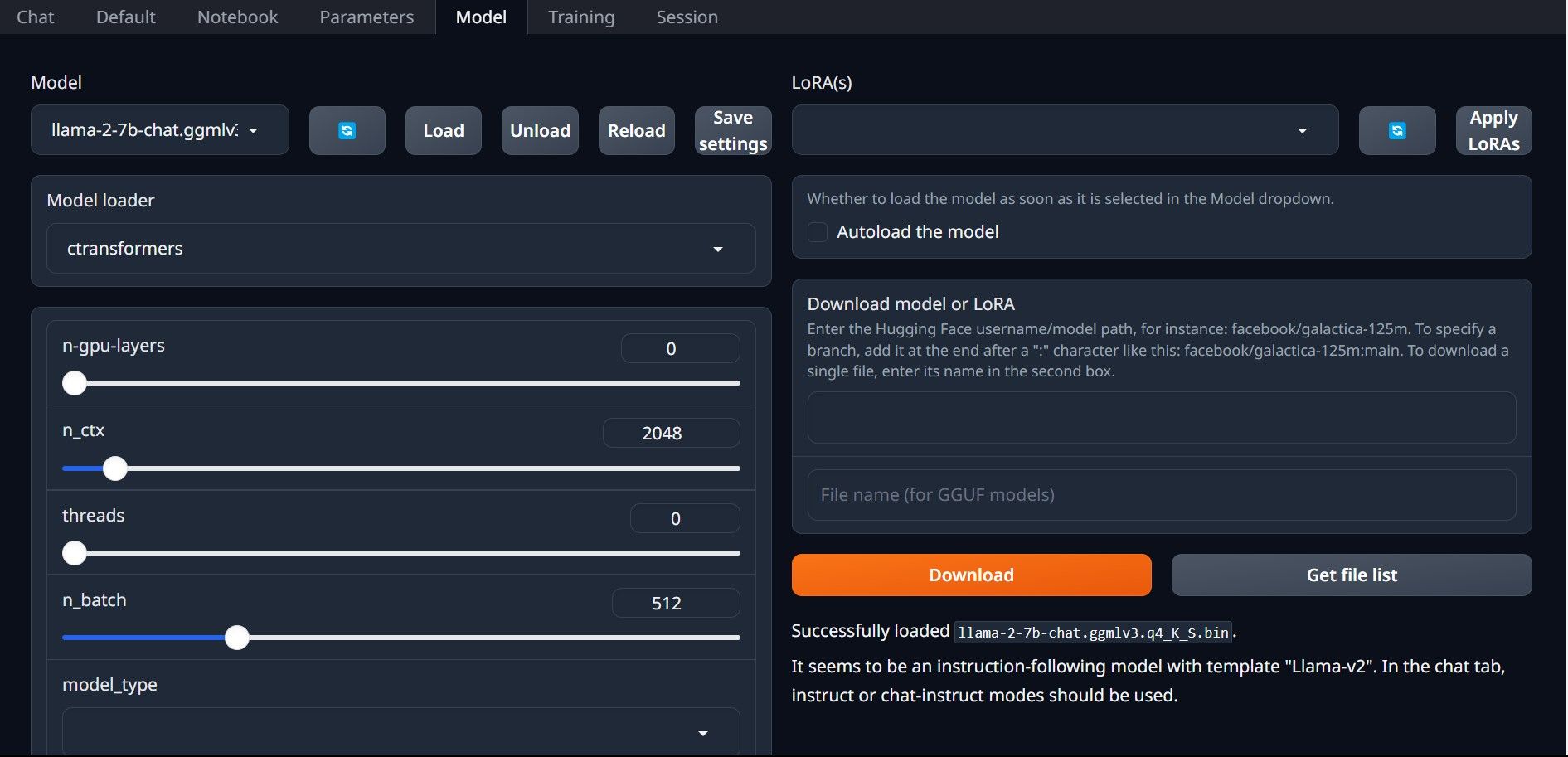

- 在图形用户界面上方的标签栏中,单击“模型”选项卡。在模型下拉菜单中点击刷新按钮,并选择您的模型。

- 现在,点击模型加载器的下拉菜单。对于使用 GPTQ 模型的用户,请选择 AutoGPTQ;对于使用 GGML 模型的用户,请选择 ctransformers。最后,点击“加载”来加载模型。

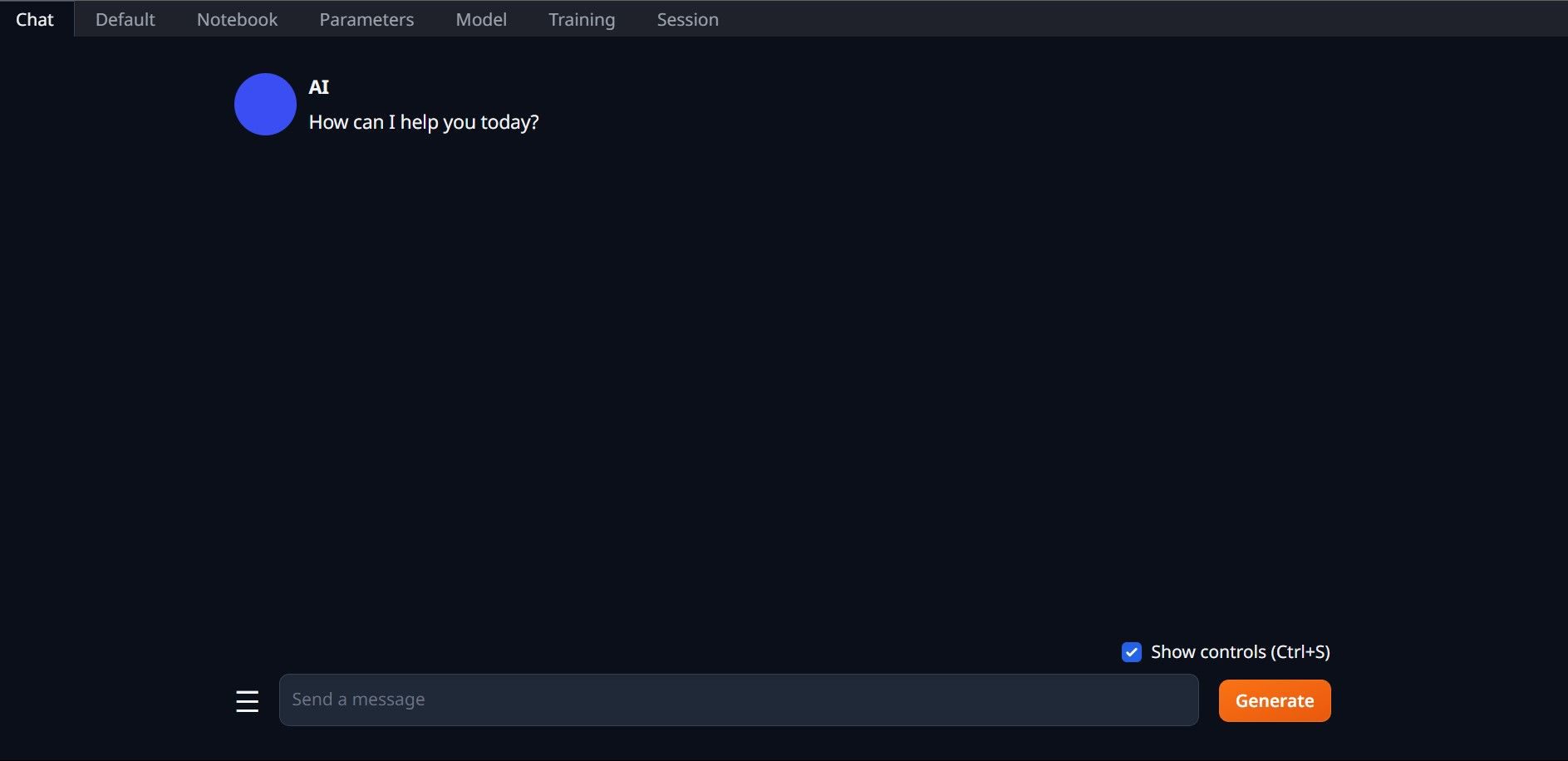

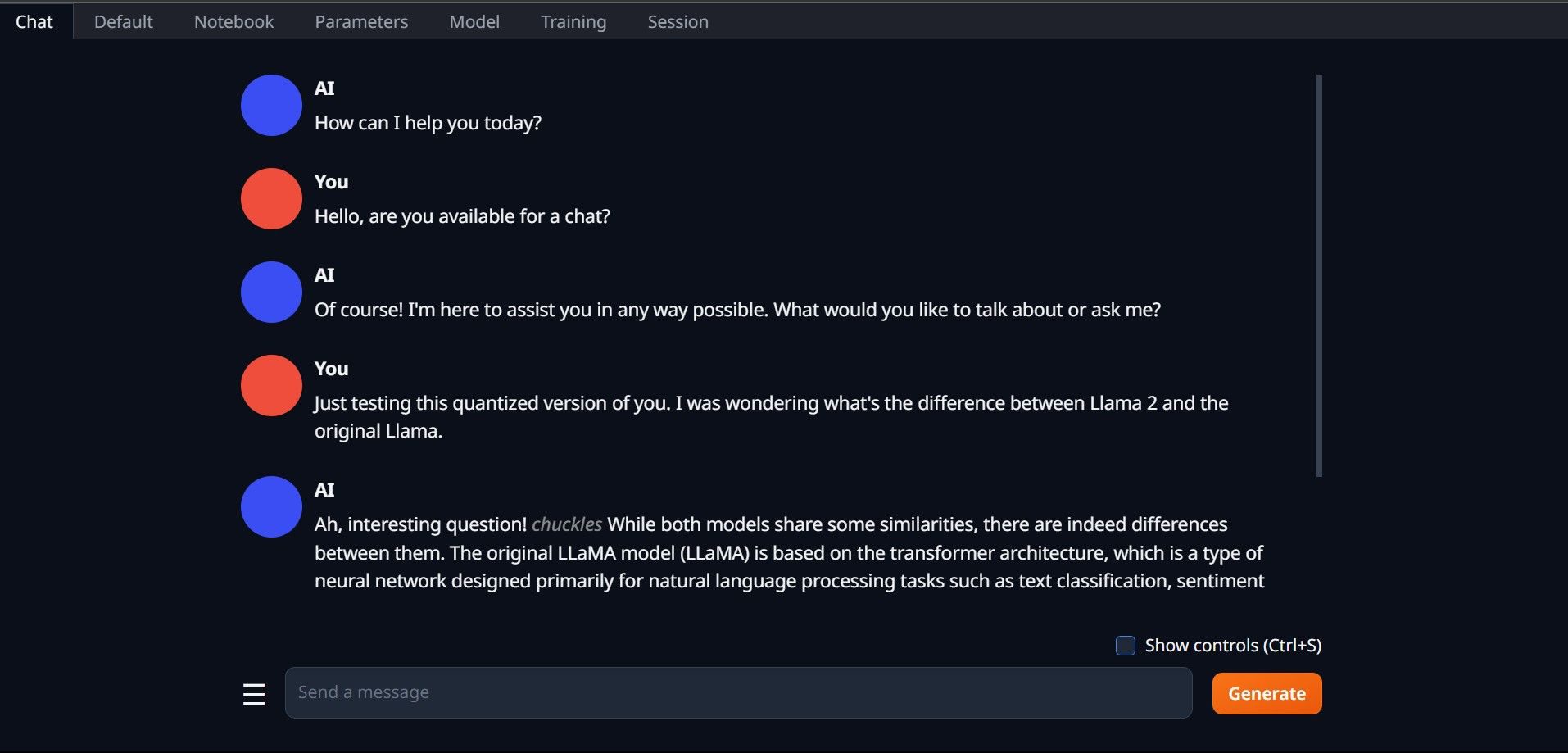

- 要使用模型,请打开“聊天”选项卡并开始测试模型。

恭喜您!您已成功在本地计算机上加载了 Llama 2 模型!

尝试其他大型语言模型 (LLM)

现在您已经了解了如何使用 Text-Generation-WebUI 在计算机上直接运行 Llama 2,您应该也能够运行除 Llama 之外的其他大型语言模型。只需记住模型的命名约定,并且只有量化版本的模型(通常是 q4 精度)才能在普通个人电脑上加载。HuggingFace 上提供了许多量化的大型语言模型。如果您想探索其他模型,请在 HuggingFace 的模型库中搜索 TheBloke,您应该会找到许多可用的模型。